你的个人数据已沦为人工智能的练习手册,而且拿不回去啦!

众所周知,艺术来源于生活。不过,如果艺术仿效你的个人生活、你的兴趣和爱好,而且效仿得好到真实和虚假之间的边界都越来越模糊了,怎么办?

不知不觉中,我们已经成为了最新人工智能技术的样本。人工智能从互联网上收集数千兆字节的未经过滤的数据,然后自己学习。收集的数据也许包含我们的个人照片、医疗图像,甚至有版权的内容。基本上是任何曾经在网上发布过的资讯。

文本生成图像的系统,如 DALL-E 2、Midjourney 和 Stable Diffusion 等系统,在数据的识别、解释和处理等方面上逐渐变得越来越好。具有文本信息提示,这些系统生成基于所掌握的知识的详细图像。目前,这些图片并不完美,但是其真实感正在变得越来越强。尽管听起来很不靠谱,但有一天,该算法可能会生成你自己的图像。我们至少也不能排除这种可能性。

当然,这一种情况发生在一个普通人身上的可能性是挺小的。然而,对于公众人物来说,其形象被用来欺骗易受骗的人的风险要高得多。TA们的公开数据已经保证人工智能对TA们了如指掌,所以攻击者唯一需要思考的就是台词了。

Stable Diffusion 的图像:马斯克在莫奈风格的画中,盖茨在汽车附近拿着步枪。图片来源:Stability AI。

现在也没什么办法可以保护好自己免受人工智能收集个人信息的入侵。用户能做的,只是在人工智能窃取并使用数据之后把自己数据移除。你可以在 Have I Been Trained 和其他之类网站上查看,检查他们要求,并投诉。然后,等。

技术之城:令人敬畏

人工智能图像生成器在技术层面来讲,还是一个新生儿。这就是它们直到现在还没有被监管的原因之一。最著名和最先进的从描述中生成图像的工具之一是 DALL-E。这种文本图像编码器于去年1月首次向有限的受众发布,并于今年9月开始向公众提供。据该工具背后的公司 OpenAI 称,大约150万人已经在使用这项服务,"每天创造200多万张图片"。

在其公开发布后,OpenAI 取消了对编辑人类面部的限制。但与大多数竞争对手不同,OpenAI 引入了一些预防措施。例如,该公司表示,它已经改进了其人工智能过滤算法,以阻止性、政治、暴力和仇恨内容。DALL-E 的政策还禁止用户上传"未经本人同意的任何人的图像"和用户没有权利的图像。

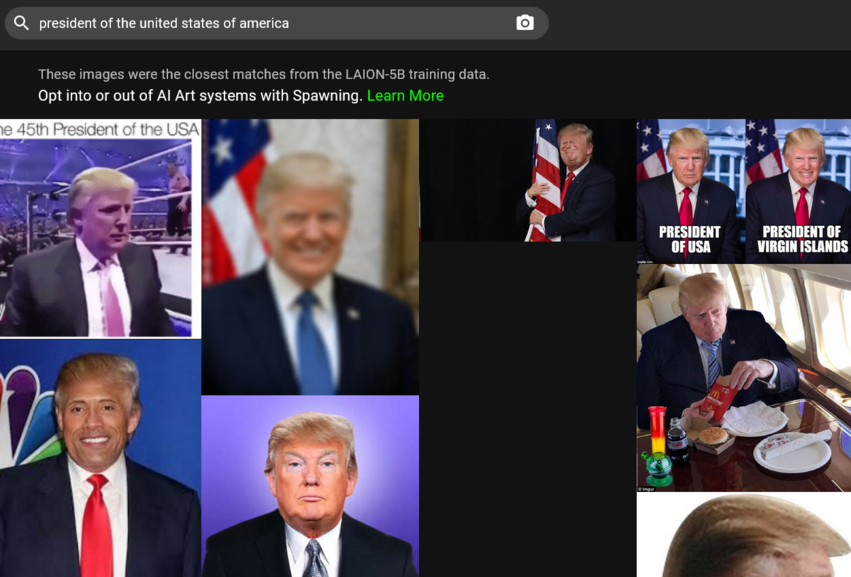

DALL-E 似乎没有切实可行的方法来执行这一特定的政策,只能相信用户的话。为了最大限度减少可能的滥用风险,开发商此前曾表示,他们已经通过"限制"其记忆人脸的能力来加强 DALL-E 的学习过程。这样做主要是为了防止人工智能创造出名人的“二重身”,并将他们放到不适当的环境中。OpenAI 的内容政策禁止"政治家、投票箱或其他可能被用来影响政治进程或竞选的内容"的图像,并警告不要试图创建公共人物的图像。用户报告说,DALL-E 对提到名人 和政治家的请求不作回应。

无论名称,OpenAI 的文本称图像机制并不是开源的,是有道理。OpenAI 争论,“自由访问系统的原始组件是给滥用者敞开了大门的。TA们可以在主观上训练不适当的内容,如色情和暴力场景。”

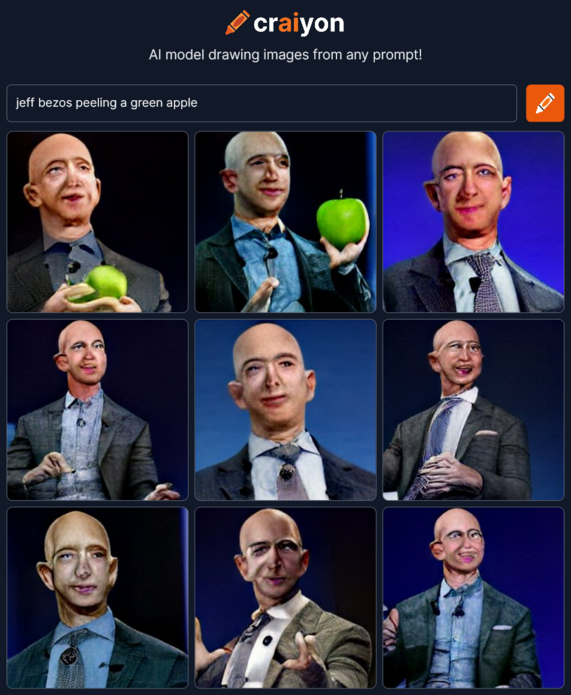

然而,其他人已经接受了 OpenAI 的想法。受到 DALL-E 鼓动,一群人工智能爱好者创建了Crayion(前身为 DALL-E mini)。这是指一个免费的开源人工智能图像生成器,由文本组成。但它是在相对较小的未经过滤的互联网数据样本上进行训练的,大约1500万个图像对和相应的备用文本,所产生的图画,尤其是人的图画,看起来远没有那么逼真。

比 Crayion 先进得多、比 DALL-E 2 限制少得多的是 Stable Diffusion。这是初创公司 StabilityAI 在今年8月发布的一个开源模型。系统允许生成从未发生过的公众面孔、抗议活动和事故的图像,并有可能被用于虚假宣传活动。

Stable Diffusion 的图像,白宫的烟雾和迪斯尼乐园的抗议活动。图片来源:Stability AI。

只要你同意一系列规则,Stable Diffusion 允许用户发布和销售自己的图像。例如,用户不得使用该系统模型来违反法律,伤害未成年人,分发"以伤害他人为目"的假货,"生成或分发可用于伤害他人的个人信息",提供医疗建议,侵犯版权,冒充他人,或"诽谤、羞辱或以其他方式骚扰他人”。显然,检查内容是否违规的责任就落在第三方用户和受害者自己身上了。

让事情变得更糟(或更好,取决于你的观点吧)的是,人工智能模型越来越善于模仿人类的风格。在科罗拉多州博览会上,一位非职业艺术家因使用另一种将文本转化为图像的人工智能工具。Midjourney 创作的作品而获得数字艺术比赛的一等奖后,爆发了这场争议。不久前,《大西洋月刊》的一名记者在使用 Midjourney 为一份通讯建立了两张阴谋论倡导者 Alex Jones 的图片后,在 Twitter 上捅了马蜂窝。

可以说,随着时间的推移,基于人工智能的工具只会变越来越好用。创建自己的将文本转换到图像的 Google 人工智能模型,即 Imagen, 的研究人员声称,本模型在准确性和图像质量方面已经超过了最新版本的 DALL-E,即 DALL-E 2.。

图像合成的人工智能将如何影响艺术和现实,还有待观察。这在很大程度上将取决于开发者是否能够驯服人工智能怪物,以及它将继续依靠的数据。

数据到底来自哪里呢?

人工智能模型,如 DALL-E 和 Stable Diffusion,在从 Web 处处收集的巨大数据库的基础上而“训练”。

举一个例子吧。DALL-E 2 模型是在互联网上已有的6.5亿个文本图像上训练的。Stability AI 主要在 LAION-5B 数据集的英文子集上进行训练。LAION 5B(大规模人工智能开放网络)是一个包含56亿张在线收集的图像的开放数据集。其中,23亿是英文的图像文本集,使 LAION 5B 成为世界上最大的此类开放数据集。其前身 LAION-400 包含4.13亿个配对,被 Google 用于 Imagen 训练。这个数据集最初是由研究人员创建的,试图复制对公众关闭的 OpenAI 数据集。

LAION 将自己描述为一个非营利组织,其使命是"围绕大规模多模态模型学习进行民主化研究和实验"。这是一项崇高的使命,但却要以牺牲隐私为代价。研究人员为寻找图像文本对而分析的数据来自 Common Crawl。这是另一个非营利组织,每月爬行网络并免费提供 PB 级的数据。在一份技术说明中,Common Crawl 指出,他们"只是在互联网上找到了这些数据",而"对内容不进行担保,如果内容有问题也不负责任"。

考虑到数据的来源,资讯会包括个人信息、敏感图像和受版权保护的内容。不过,这并不令人惊讶。10月,ArtTechnica 报道一位人工智能艺术家如何在 LAION-5B 数据集中找到自己的医疗照片。这些照片是由艺术家的医生(已故的)拍摄的。原来,这些数据只供这位医生个人使用。

值得注意的是,LAION 并不托管这些图片,而只是提供可以下载这些图片的 URL。因此,据称该公司不能对用户的个人数据或工作成果承担责任。事实证明,从法律上讲,我们在试图找到那些可能滥用数据的责任人时却屡屡碰壁。另一个问题是,选择退出人工智能训练是不可能的,因此用户将不得不努力追溯性地删除自己的数据。

如何才可以从人工智能中移除自己的个人数据?

首先,要请求从人工智能训练数据库中删除自己的图像。你肯定会在那里找到它们。这似乎是一项艰巨的任务,因为有数以百万计的图像文本对需要进行处理。好消息是,现在有了一个捷径。10月,Spawning AI 推出了一个 Have I Been Trained?网站。用户可以搜索 LAION-5B 数据库,给它一个图像或文字线索。或者你可以随便玩玩本算法(要小心,它可以产生一些非常奇怪的结果)。

如果你找到了自己的图像,请填写 LAION 的 GDPR 页面上的退出表格。LAION 承诺对该消息进行调查。如果发现有关图片违反欧盟数据保护法,将从其控制的所有数据存储中,并在今后的发布中都删除。

Spawning 还在开发了一些工具,允许艺术家选择是否"参与大型人工智能模型的训练",并"设置使用其艺术风格的权限"。用户可以在该公司的网站上申请对这些工具的测试 Beta 访问。Stable Diffusion 支持 Spawning 的努力,并表示它将创建"一个非自动化的艺术家和其他人的选择系统,服务机构可以与领先机构合作使用"。

DALL-E 允许人们在发现自己的作品未经同意被使用时,向 OpenAI 邮箱报告侵权行为。至于许多数据的原始来源,Common Crawl 似乎只列出了一个可以报告版权侵权的邮箱。

我们不禁要问,我们的数据是否会被人工智能所窃取。这部分是由于法律上的复杂性,每一方都声称对最终结果没有责任。部分原因是互联网的工作方式,它不会遗忘。

人工智能会不会生成一个与你一模一样的替身?能不能“忘记”你的长相呢?

从公众面孔的例子中可以看出,经过足够的训练,人工智能可以生成可识别的真实人物图像的能力。从技术上讲,没有什么能阻止人工智能对你的图像做同样的把戏。

OpenAI 承认,虽然 DALL-E 2 不能"生成准确的人的图像,但该模型能够从训练数据中生成具有类似特质的人"。其他人工智能模型可能也是如此。研究表明,由另一类深度学习模型,生成式对抗网络(GANs),生成的图像确实与真实人物相似。在一篇题为 This Person (Probably) Exists. Identity Membership Attacks Against GAN Generated Faces(这个人(可能)存在。对 GAN 生成的人脸身份攻击)的论文中,研究人员表明,TA们能够重新识别那些为生成"不存在的人"的图像做出贡献的人的身份。

至于人工智能模型是否可以"忘掉",忘记他们已经了解到的关于你的信息,Stability AI 首席执行官 Emad Mostaque 告诉 Ars Technica,这是可能的,但需要一些调整或额外工作。关键问题是开发商是否愿意投入大量的精力。毕竟TA们不需要这样做。

解决人工智能问题。一项不可能完成的任务?

不可否认,人工智能先驱者取得的成果令人钦佩。事实上,一些人正在制作开放源代码,而且在稳定性人工智能的情况下,在不禁止商业使用的许可下发布,这将有助于研究人员、创造者和人工智能的发展。

但它也可能产生相反的效果。很难阻止攻击者使用开源模式。最重要的也许是,现在艺术家和普通人没有办法拒绝成为人工智能创造的最终产品的一部分了。此外,即使我们想从训练数据中删除我们的图像,我们也必须依靠公司的善意。

随着技术的普及,越来越多的人将受到这些问题的影响。例如,Microsoft 最近宣布,它将把自己的两个应用程序整合到 DALL-E 2 中。其中一个应用程序是 Image Creator。它将在 Microsoft 的 Bing 搜索引擎和 Edge 中免费使用。

目前的情况需要加以规范。这是否将是对数据集的审查,一个受到各方尊重的透明的退出机制,还是其他一些方法,我们不得而知。但就目前而言,人工智能图像文本生成器仍然是对个人数据的威胁,这种威胁只会越来越大。