Tus datos personales se están utilizando para el entrenamiento de IA y no podrás recuperarlos

El arte imita a la vida, y todos lo sabemos. Pero, ¿y si el arte imitara tu vida e intereses personales, y lo hiciera tan bien que los límites entre lo real y lo imaginario ya no estuvieran claros?

Puede que no lo sepamos, pero ya nos estamos convirtiendo en modelos para la tecnología de inteligencia artificial moderna entrenada en muchos terabytes de datos extraídos de la Web, con muy poco filtrado. Estos datos incluyen fotos personales, imágenes médicas e incluso contenido protegido por derechos de autor. En otras palabras, incluye cualquier imagen disponible online.

Los modelos de aprendizaje profundo de texto a imagen como DALLE-E 2, Midjourney y Stable Diffusion están mejorando cada día en el reconocimiento, la interpretación y la resignificación de estos datos. Cuando se alimentan con una entrada de texto, producen imágenes detalladas basadas en lo que han aprendido. Si bien estas imágenes aún no son fotos perfectas, se están volviendo cada vez más realistas. Por mucho que esto no parezca plausible, el algoritmo puede en cualquier momento mostrar lo que quiere y es plausible que, en el futuro, esto no se puede controlar.

Las posibilidades de que esto suceda son escasas. Sin embargo, es probable que las figuras públicas tengan su imagen explotada y la utilicen para engañar a los incautos. Las IA ya se han alimentado de sus datos disponibles públicamente y ya pueden reconocerlo de inmediato. Por lo tanto, todo lo que necesita una persona malintencionada es crear una entrada de texto lo suficientemente inteligente.

Imágenes de Elon Musk al más puro estilo Monet y Bill Gates con un rifle junto a un coche, realizadas por Stable Diffusion. Imagen cortesía de Stability AI.

Actualmente no es posible salvarte del feed de datos de IA. Solo puedes eliminar tus datos de este tipo de directorio después de que ya se haya utilizado como muestra de entrenamiento para una IA. Para esto, puedes usar sitios como Have I Been Trained. Asegúrate de cumplir con los requisitos, presenta un reclamo y espera lo mejor.

El estado de la tecnología: inspirador y confuso

Los generadores de imágenes de inteligencia artificial son una novedad que está en boca de todos. Eso explica por qué han evadido la regulación hasta ahora. Una de las herramientas más avanzadas para crear imágenes a partir de una descripción es DALL-E. El codificador de texto a imagen se lanzó en enero pasado a través de una lista de espera y se hizo disponible para el público en general en septiembre. Alrededor de 1,5 millones de personas ya están usando el servicio,“creando más de 2 millones de imágenes al día” según OpenAI, la empresa detrás de la herramienta.

Además de la lista de espera, OpenAI no restringió la edición de rostros humanos. Pero a diferencia de sus competidores, OpenAI ha adoptado algunas medidas de seguridad: la empresa afirma que ha refinado el algoritmo de filtrado de la herramienta para bloquear contenido sexual, político, violento y de odio. La política de DALLE-E también prohíbe a los usuarios cargar "imágenes de cualquier persona sin su consentimiento" e imágenes sobre las que los usuarios no tienen derechos.

Parece que DALLE-E no tiene una forma práctica de garantizar que se cumpla esta política en particular. En un intento por minimizar los riesgos de un posible uso indebido, los desarrolladores dijeron anteriormente que habían perfeccionado el proceso de capacitación de DALL-E, "limitando" su capacidad para memorizar rostros. Esto se hizo principalmente para que la IA no produzca imágenes de figuras públicas o termine colocándolas en un contexto engañoso. La política de contenido de OpenAI prohíbe específicamente las imágenes de “políticos, urnas o cualquier otro contenido que pueda usarse para influir en el proceso político o una campaña” y envía una advertencia sobre los intentos de crear imágenes de figuras públicas. Los usuarios informaron que DALL-E parece no responder a las entradas que mencionan celebridades y políticos.

A pesar de su nombre, OpenAI no es de código abierto y hay una buena razón para ello. OpenAI argumenta que "hacer que los componentes básicos del sistema estén disponibles gratuitamente da lugar a que personas malintencionadas lo entrenen para mostrar contenido inapropiado, como pornografía y violencia gráfica".

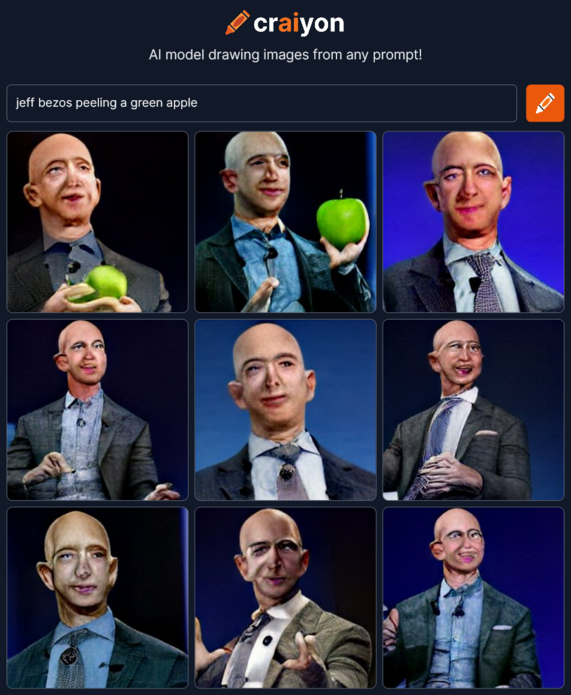

Otros, sin embargo, aprovecharon el vacío legal dejado por OpenAI. Inspirándose en DALL-E, un grupo de entusiastas de la inteligencia artificial creó Crayion (anteriormente conocido como DALLE-E mini), un generador de imágenes a partir de texto de código abierto. Pero dado que se entrenó en una muestra relativamente pequeña de datos de Internet sin filtrado (alrededor de 15 millones de pares de imágenes y el texto correspondiente), los dibujos resultantes, especialmente los relacionados con personas, son significativamente menos realistas.

Mucho más avanzado que Crayion y significativamente menos restrictivo que DALLE-E 2 es el Stable Diffusion, un modelo de código abierto lanzado por la startup StabilityAI en agosto de este año. Permite crear imágenes de figuras públicas, protestas y accidentes que nunca sucedieron y pueden ser utilizados en actos de desinformación.

Imágenes de Stable Diffusion que muestran humo saliendo de la Casa Blanca y protestas en Disney. Imagen cortesía de Stability AI.

Stable Diffusion otorga permiso para distribuir y vender los resultados si el usuario acepta una lista de reglas. Por ejemplo, no se puede usar la plantilla para violar la ley, dañar a menores, difundir información falsa "con el fin de causar daño a otros", "generqr o difundir información de identificación personal que podría usarse para causar daño en un individuo”, ofrecer asesoramiento médico, infringir los derechos de autor, hacerse pasar por individuos y “difamar, menospreciar o acosar a otros”. Una vez más, es difícil decir cómo pretende castigar la empresa a quienes infrinjan estas reglas. La carga recae por completo en aquellos que no tienen conexión con el sitio o en las víctimas que encuentran el contenido prohibido por sí mismas.

Para empeorar las cosas (o no, depende de tu punto de vista), hay el hecho de que los modelos de inteligencia artificial son cada vez mejores para imitar las habilidades humanas y se acercan cada vez más a engañar a los observadores. La controversia surgió después de que un artista no profesional ganó el primer lugar en la feria de arte digital de Colorado de este año con un trabajo creado en Midjourney, otra herramienta de IA de texto a imagen. No hace mucho tiempo, el periodista de The Atlantic provocó una discusión en Twitter después de usar Midjourney para inventar dos imágenes del teórico de la conspiración Alex Jones en un boletín de noticias.

Es seguro pensar que las herramientas impulsadas por IA mejorarán aún más a medida que pase el tiempo. Los investigadores involucrados en el modelo de IA de texto a imagen de Google, Imagen, afirmaron que ya está funcionando mejor que la última versión de DALLE-E, DALLE-E 2, en términos de calidad y precisión de imagen.

Hay mucha especulación e incertidumbre sobre cómo los sintetizadores de imágenes basados en IA afectarán el arte y la realidad tal como los conocemos. Esto dependerá en gran medida de la disposición de los desarrolladores para domar a sus monstruos de realidad virtual, pero también del tipo de datos de los que se alimentarán.

¿De dónde provienen los datos?

Los modelos de IA como DALLE-E y Stable Diffusion se entrenan en bases de datos gigantes recopiladas de Internet.

Así, DALLE-E 2 se alimentó con 650 millones de pares texto-imagen que ya estaban disponibles en internet. La IA de estabilidad fue entrenada principalmente con el subconjunto en inglés de la base de datos LAION-5B. La LAION 5B ("Red Abierta de Inteligencia Artificial a Gran Escala") es una base de datos de código abierto que contiene 5.600 millones de imágenes recopiladas de la Web, incluidos 2.300 millones de pares imagen-texto en inglés, que le garantizan la posición de la más grande del mundo en el categoría. Su predecesor, el LAION-400, contiene 413 millones de pares y fue utilizado por Google para entrenar Imagen. Esta base de datos fue creada originalmente por investigadores en un intento de replicar la base de datos OpenAI, cerrada al público.

LAION se describe a sí misma como una organización sin fines de lucro con la misión de “democratizar la investigación y la experimentación con modelos de entrenamiento multimodal a gran escala”. A pesar de lo noble que es la misión, tiene un alto costo para la privacidad. Los datos recopilados por los investigadores provienen de Common Crawl, otra organización sin fines de lucro que rastrea la Internet todos los meses y ofrece petabytes de datos de forma gratuita al público. En estos términos de servicio, Common Crawl establece que "solo encuentran los datos en la web" y "no garantizan el contenido ni responden si hay algún problema con él"

Dada la fuente de los datos, no sorprende que la información de identificación personal (PII), las imágenes confidenciales y el contenido con derechos de autor puedan colarse en el conjunto de datos. ArtTechnica informó el mes pasado cómo un artista de IA descubrió sus propias fotos médicas en el conjunto de datos LAION-5B. Las fotos fueron tomadas por el médico del artista (ya fallecido) solo para uso privado.

Vale la pena señalar que LAION no aloja las imágenes, sino que solo proporciona URL donde se pueden descargar. Por lo tanto, LAION presumiblemente no se hace responsable de la divulgación de datos personales o profesionales. También significa que, legalmente, tratar de encontrar a los culpables de un posible mal uso de los datos es prácticamente inútil. Otro problema es que no hay forma de cancelar el entrenamiento de IA, y eliminar sus datos después de que se hayan utilizado requiere mucho esfuerzo.

¿Cómo eliminar los datos personales que alimentaron una IA?

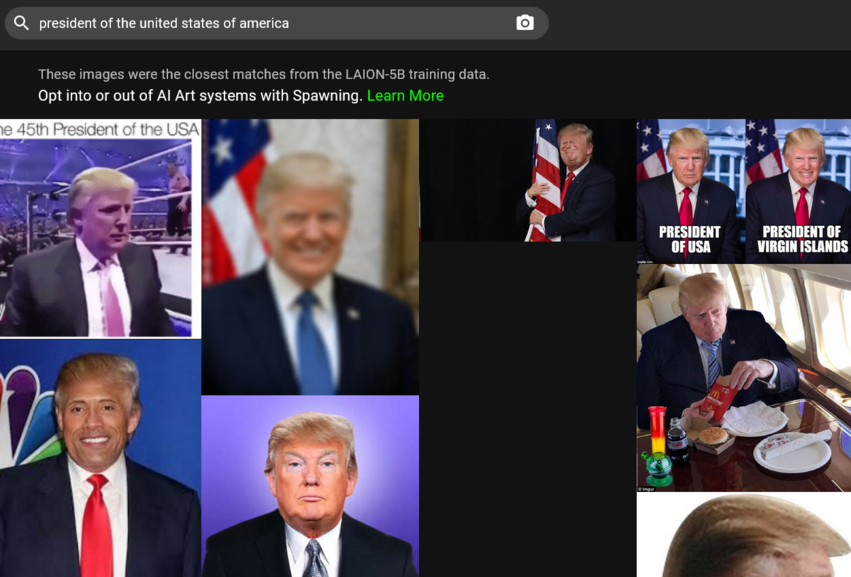

Para comenzar, para solicitar la eliminación de sus imágenes del conjunto de datos de entrenamiento de IA, debes encontrarlas allí. Puede parecer una tarea desalentadora dado que hay millones de pares de imagen a texto para pasar. Afortunadamente, ahora hay un atajo para esto. El mes pasado, una empresa llamada Spawning AI lanzó Have I Been Trained?, un sitio web en el que puede buscar en la base de datos LAION-5B introduciendo una imagen o un mensaje de texto. O simplemente puedes jugar con el algoritmo (cuidado, puede darte algunos resultados muy curiosos).

Si logra encontrar su imagen, deberá completar un formulario de eliminación en la página de LAION GDPR. LAION promete investigar el informe y si encuentra que dicha imagen viola la ley de protección de datos de la UE, la eliminará de todos los repositorios de datos bajo su control y de futuras versiones

Generation también está creando herramientas que permitirían a los artistas "optar por participar o no en el entrenamiento de grandes modelos de IA", así como "establecer permisos sobre cómo se usa su estilo y semejanza". Los usuarios pueden suscribirse, si es para beta acceso a las herramientas en el sitio web de la empresa. Stable Diffusion, que apoya los esfuerzos de Spawning, dice que creará "un sistema de aceptación y exclusión voluntaria para artistas y otros que los servicios pueden usar en asociación con organizaciones líderes".

DALLE-E permite a las personas que descubren que su trabajo se ha utilizado sin su consentimiento para informar de la infracción al correo electrónico de OpenAI. En cuanto a la madre de los dragones, la fuente original de gran parte de los datos, Common Crawl, parece enumerar solo un apartado de correos donde puede denunciar una infracción de derechos de autor.

En resumen, nos quedamos con nuestros propios dispositivos cuando se trata de asegurarnos de que la IA no absorba nuestros datos. Esto se debe en parte al dilema legal cuando cada lado no se responsabiliza por el resultado final. En parte, así es como funciona Internet: nada se olvida.

¿Revelará una IA tu apariencia exacta y podrá "desaprender" cómo te ves?

Como se ve en el ejemplo de las figuras públicas, la IA, con suficiente entrenamiento, puede generar imágenes reconocibles de personas reales. Técnicamente, no hay nada que impida que la IA haga el mismo truco con tu imagen.

OpenAI admite que, si bien DALLE-E 2 no puede “generar literalmente imágenes exactas de personas, es posible generar un parecido similar con alguien en los datos de entrenamiento”. Es probable que lo mismo sea cierto para otros modelos de IA. La investigación ha demostrado que las imágenes generadas por otra clase de modelos de aprendizaje profundo: redes adversarias generativas

(GAN): se asemejan a personas reales. En el artículo titulado Esta persona (probablemente) existe. Los ataques de asociación de identidad contra rostros generados por investigadores de GAN demostraron que era posible volver a identificar identidades de origen que contribuían a generar imágenes de “personas inexistentes.

"Si bien algunas muestras solo muestran similitudes, otras imágenes generadas comparten características idiosincrásicas de identidades de entrenamiento", encontraron los investigadores.

En cuanto a la posibilidad de que los modelos de IA desaprendan lo que ya aprendieron sobre ti, Emad Mostaque, director ejecutivo de Stability AI, le dijo a Ars Technica que es posible, pero requiere algunos ajustes o trabajo adicional. La gran pregunta es si los desarrolladores están dispuestos a hacer todo lo posible para ello, ya que no son obligados a hacerlo.

Resolviendo el problema de la IA: ¿una misión imposible?

No se puede negar que los resultados obtenidos por estos pioneros de la Inteligencia Artificial son admirables. El hecho de que algunos de ellos lo hayan hecho de código abierto y, en el caso de Stability AI, lo hayan liberado bajo una licencia permisiva que no prohíbe el uso comercial, ayudará a los investigadores, desarrolladores y al progreso en varias áreas.

Sin embargo, esto también puede salir muy mal, ya que es extremadamente difícil evitar que personas malintencionadas utilicen el modelo de código abierto. Y lo más importante, quizás, es que actualmente no hay forma de que los artistas y la gente de a pie puedan optar por no formar parte de un producto final generado por la IA. Además, aunque queramos eliminar nuestras imágenes de los datos de formación, tenemos que confiar en la buena voluntad de las empresas.

Estos problemas afectarán a un número aún mayor de personas a medida que estas tecnologías se generalicen. Por ejemplo, Microsoft ha anunciado recientemente que está integrando dos de sus aplicaciones con DALL-E 2. Una de las aplicaciones es Image Creator, que estará disponible de forma gratuita en el buscador Bing de Microsoft y en Edge.

La situación exige una regulación. Podría ser una cuidadosa curación del conjunto de datos, un claro mecanismo de exclusión respetado por todas las partes o algún otro método de prevención, no lo sabemos. Pero tal y como están ahora, los generadores de imágenes de IA a partir de texto siguen siendo una amenaza para la privacidad, y eso seguramente empeorará.