Ваши личные данные стали учебным пособием для ИИ, и вам их не вернуть

Искусство подражает жизни. Но что если оно станет воспроизводить ваш образ и личную жизнь настолько хорошо, что грань между реальным и нереальным сотрётся?

Сами того не подозревая, мы становимся моделями для новейшей технологии искусственного интеллекта. Она обучается на терабайтах плохо отфильтрованных данных, собранных со всего интернета. Эти данные могут включать наши личные фотографии, медицинские изображения и даже контент, защищённый авторским правом, — в общем, всё, что когда-либо было опубликовано в сети.

Модели глубокого обучения преобразованию текста в изображение, такие как DALL-E 2, Midjourney и Stable Diffusion, всё лучше распознают, интерпретируют и используют эти данные. Получив текстовую подсказку, они создают детальные изображения на основе изученного материала. И хотя эти изображения ещё не идеальны, они становятся всё более фотореалистичными. Как бы неправдоподобно это ни звучало, однажды алгоритм может сгенерировать ваше собственное изображение — по крайней мере, этого нельзя исключать.

Вероятность того, что всё это произойдёт с обычным человеком, конечно, невелика. Однако для публичных лиц риск того, что их изображение будет использовано для обмана доверчивых людей, гораздо выше. Искусственный интеллект вдоволь наелся их открытыми данными и уже знает их в лицо, поэтому единственное, что нужно придумать злоумышленнику, — это умная текстовая подсказка.

Илон Маск на картине в стиле Моне и Билл Гейтс с винтовкой возле автомобиля. Изображения Stable Diffusion предоставлены компанией Stability AI.

Пока не существует способа защитить себя от попадания в поток данных ИИ. Вы можете удалить свои данные из этого импровизированного искусствоведческого кружка только постфактум, то есть после того, как они уже были использованы в качестве обучающего образца для ИИ. Для этого вам нужно найти их на сайтах типа Have I Been Trained, убедиться, что они соответствует требованиям, подать жалобу и надеяться на лучшее.

Технология: внушающая трепет и опасения

ИИ-генераторы изображений — новинка, что отчасти объясняет, почему их до сих пор не регламентировали. Один из самых известных и продвинутых инструментов для создания изображений из описания — DALL-E. Этот кодировщик текста в изображение был впервые выпущен для ограниченного круга лиц в январе прошлого года, а широкой публике стал доступен в сентябре этого года. Около 1,5 миллионов человек уже пользуются сервисом, «создавая более 2 миллионов изображений в день», если верить компании OpenAI, стоящей за этим инструментом.

После публичного релиза OpenAI сняла ограничения на редактирование человеческих лиц. Но, в отличие от большинства конкурентов, OpenAI ввела некоторые меры предосторожности. Так, компания заявила, что усовершенствовала алгоритм фильтрации ИИ, чтобы блокировать материалы на тему секса, политики, насилия и ненависти. Также политика DALL-E запрещает пользователям загружать «изображения кого-либо без их согласия» и изображения, на которые у пользователей нет прав.

Похоже, что у DALL-E нет никакого практического способа добиться соблюдения этой конкретной политики, кроме как верить пользователям на слово. Стремясь минимизировать риски возможного злоупотребления, разработчики ранее заявляли, что они доработали процесс обучения DALL-E, «ограничив» его способность запоминать лица. Это было сделано в первую очередь для того, чтобы ИИ не создавал двойников известных личностей и не помогал помещать их в не соответствующий действительности контекст. Контентная политика OpenAI запрещает изображения «политиков, урн для голосования или другого контента, который может быть использован для влияния на политический процесс или агитации» и предостерегает от попыток создания изображений публичных фигур. Пользователи сообщают, что DALL-E действительно не отвечает на запросы, в которых упоминаются знаменитости и политики.

Вопреки названию, у чудо-системы преобразования текста в изображение OpenAI нет открытого исходного кода, и на это есть веская причина. OpenAI утверждает, что «свободный доступ к необработанным компонентам системы оставляет дверь открытой для злоумышленников, которые могут обучать их на субъективно неприемлемом контенте, таком как порнография и сцены насилия».

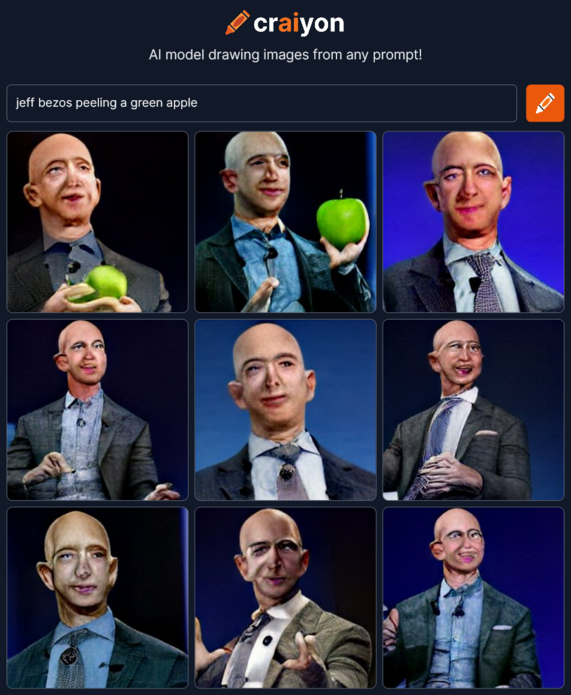

Другие, однако, подхватили идею OpenAI. Вдохновившись DALL-E, группа ИИ-энтузиастов создала Crayion (ранее DALL-E mini), бесплатный ИИ-генератор изображений из текста с открытым исходным кодом. Но он обучается на относительно небольшой выборке нефильтрованных данных из интернета — около 15 миллионов пар изображений и соответствующих альтернативных текстов — и получаемые рисунки, особенно людей, выглядят гораздо менее реалистично.

Гораздо более продвинутой, чем Crayion, и гораздо менее ограничивающей, чем DALL-E 2, стала Stable Diffusion — модель с открытым исходным кодом, выпущенная стартапом StabilityAI в августе этого года. Она позволяет генерировать изображения публичных лиц, протестов и несчастных случаев, которые никогда не происходили и потенциально могут быть использованы в дезинформационных кампаниях.

Дым, поднимающийся от Белого дома, и протесты в Диснейленде. Изображения Stable Diffusion предоставлены компанией Stability AI.

Stable Diffusion разрешает распространять и продавать полученные результаты при условии, что вы согласны со списком правил. Например, вы не можете использовать модель для нарушения закона, причинения вреда несовершеннолетним, распространения фейков «с целью причинения вреда другим», «генерирования или распространения личной информации, которая может быть использована для причинения вреда человеку», предоставления медицинских консультаций, нарушения авторских прав, выдачи себя за других людей, а также «клеветы, унижения или иного преследования других». По всей видимости, бремя выявления запрещённого контента ложится на сторонних пользователей и самих жертв.

Усугубляет ситуацию (или улучшает, в зависимости от вашей позиции) тот факт, что ИИ-модели становятся всё более умело имитируют стиль человека. Полемика разгорелась после того, как непрофессиональный художник получил первый приз на конкурсе цифрового искусства на ярмарке штата Колорадо за работу, созданную с помощью Midjourney — ещё одного ИИ-инструмента для преобразования текста в изображение. Не так давно журналист The Atlantic разворошил осиное гнездо Twitter после того, как с помощью Midjourney создал два изображения сторонника теории заговора Алекса Джонса для рассылки.

Можно с уверенностью сказать, что со временем инструменты, основанные на искусственном интеллекте, станут только лучше. Исследователи, создавшие собственную ИИ-модель Google для преобразования текста в изображение, Imagen, утверждают, что она уже превосходит последнюю версию DALL-E — DALL-E 2 — по точности и качеству изображения.

Пока неясно, как синтезирующий изображения искусственный интеллект повлияет на искусство и реальность. Во многом это будет зависеть от того, удастся ли разработчикам приручить ИИ-монстра, а также от данных, которыми он будет продолжать питаться.

Откуда берутся данные?

Такие модели ИИ, как DALL-E и Stable Diffusion, обучаются на огромных массивах данных, собранных со всего интернета.

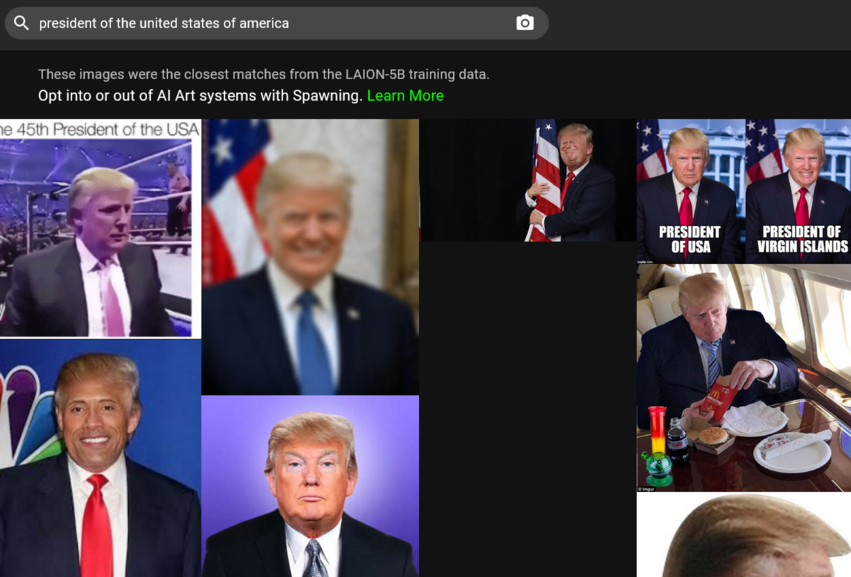

К примеру, модель DALL-E 2 обучалась на 650 миллионах пар текст-изображение, уже имеющихся в интернете. Stability AI обучалась в основном на английском подмножестве набора данных LAION-5B. LAION 5B (Large-scale Artificial Intelligence Open Network) — это открытый набор данных, содержащий 5,6 миллиарда изображений, собранных в сети. Из них 2,3 миллиарда — пары «изображение-текст» на английском языке, что делает LAION 5B крупнейшим в мире подобным открытым набором данных. Его предшественник, LAION-400, содержит 413 миллионов пар и использовался компанией Google для обучения Imagen. Этот набор данных был изначально создан исследователями в попытке повторить набор данных OpenAI, закрытый для широкой публики.

LAION описывает себя как некоммерческую организацию с миссией «демократизировать исследования и эксперименты вокруг крупномасштабного мультимодального обучения моделей». Благородная миссия, но она дорого обходится частной жизни. Данные, которые исследователи анализировали для поиска пар «изображение-текст», были получены от Common Crawl — ещё одной некоммерческой организации, которая ежемесячно просматривает веб-страницы и предоставляет петабайты данных в свободный доступ. В техническом описании Common Crawl заявляет, что они «просто нашли данные в интернете» и «не ручаются за содержание и не несут ответственности, если с ними что-то не так».

Учитывая, откуда берутся данные, неудивительно, что в них может попасть персональная информация, деликатные изображения и контент, защищённый авторским правом. В прошлом месяце ArtTechnica сообщила, как ИИ-художница обнаружила в наборе данных LAION-5B свои собственные медицинские фотографии. Фотографии были сделаны врачом художницы (ныне покойным) и предназначались только для личного пользования этого врача.

Стоит отметить, что LAION не размещает изображения, а лишь предоставляет URL-адреса, с которых их можно скачать. Соответственно, компания якобы не может нести ответственность за распространение ваших личных данных или работы. Получается, с юридической точки зрения мы упираемся в стену, пытаясь найти виновных в потенциально неправомерном использовании данных. Ещё одна проблема заключается в том, что от обучения ИИ невозможно отказаться, и вам придётся приложить усилия, чтобы удалить свои данные задним числом.

Как удалить свои личные данные из потока ИИ?

Для начала, чтобы запросить удаление ваших изображений из обучающей базы данных ИИ, вы должны их там найти. Это может показаться непосильной задачей, учитывая, что придётся перебрать миллионы пар «изображение-текст». К счастью, теперь для этого есть короткий путь. В прошлом месяце компания Spawning AI запустила Have I Been Trained? — сайт, на котором вы можете искать в базе данных LAION-5B, давая ей изображение или текстовую подсказку. Или вы можете просто поиграть с алгоритмом (осторожнее, он может выдать очень любопытные результаты).

Если вам удастся найти своё изображение, заполните форму отказа на странице LAION, посвящённой GDPR. LAION обещает изучить сообщение и, если обнаружит, что указанное изображение нарушает закон ЕС о защите данных, удалить его из всех подконтрольных хранилищ данных и из будущих релизов.

Spawning также разрабатывает инструменты, которые позволят художникам выбирать, «участвовать или нет в обучении больших моделей ИИ», а также «устанавливать разрешения на использование их художественного стиля». Пользователи могут подать заявку на бета-доступ к инструментам на сайте компании. Stable Diffusion поддерживает усилия Spawning и заявляет, что она будет создавать «систему неавтоматического выбора для художников и других людей, которую сервисы могут использовать в партнёрстве с ведущими организациями».

DALL-E позволяет людям, обнаружившим, что их работа использовалась без их согласия, сообщить о нарушении на почту OpenAI. Что касается первоисточника большей части данных, Common Crawl, похоже, там указан только почтовый ящик, куда можно сообщить о нарушении авторских прав.

Нам остаётся только гадать, не будут ли наши данные будут поглощены искусственным интеллектом. Отчасти это связано с юридическими сложностями, когда каждая сторона утверждает, что не несёт ответственности за конечный результат. Отчасти — с тем, как работает интернет, который никогда ничего не забывает.

Сгенерирует ли ИИ вашего точного двойника и сможет ли забыть, как вы выглядите?

Как видно на примере публичных лиц, при достаточном обучении ИИ может генерировать узнаваемые изображения реальных людей. Технически ничто не мешает ИИ проделать тот же трюк с вашим образом.

OpenAI признаёт, что, хотя DALL-E 2 не может «генерировать точные изображения людей, модель способна генерировать кого-то с похожими чертами из данных обучения». То же самое, вероятно, верно и для других моделей ИИ. Исследования показали, что изображения, сгенерированные другим классом моделей глубокого обучения — генеративно-состязательными сетями (Generative Adversarial Networks, GANs) — действительно похожи на реальных людей. В работе под названием «Этот человек (вероятно) существует. Атаки на идентичность лиц, сгенерированных GAN» исследователи показали, что удалось повторно идентифицировать личность тех, кто способствовал генерации изображений «несуществующих людей».

Что касается того, могут ли модели ИИ «разучиться» и забыть то, что они уже узнали о вас, генеральный директор Stability AI Эмад Мостак сказал Ars Technica, что это возможно, но требует некоторой доработки или дополнительной работы. Главный вопрос заключается в том, готовы ли разработчики приложить для этого немало усилий — ведь они не обязаны этого делать.

Решение проблемы ИИ. Миссия невыполнима?

Нельзя не признать, что результаты, достигнутые первопроходцами в области ИИ, достойны восхищения. Тот факт, что некоторые из них делают код с открытым исходным кодом, а в случае со Stability AI выпускают его под разрешающей лицензией, не запрещающей коммерческое использование, поможет исследователям, создателям и дальнейшему прогрессу.

Но это может привести и к обратному результату — очень трудно остановить злоумышленников от использования модели с открытым исходным кодом. Самое важное, пожалуй, в том, что сейчас у художников и обычных людей нет возможности отказаться от того, чтобы стать частью конечного продукта, созданного ИИ. Более того, даже если мы захотим удалить свои изображения из обучающих данных, нам придётся рассчитывать на добросовестность компаний.

С распространением технологий эти проблемы будут затрагивать всё больше людей. Так, компания Microsoft недавно объявила, что интегрирует два своих приложения в DALL-E 2. Одно из приложений — Image Creator, которое будет доступно в поисковой системе Microsoft Bing и в Edge бесплатно.

Ситуация нуждается в регулировании. Будет ли это тщательное изучение наборов данных, прозрачный механизм отказа от использования, соблюдаемый всеми сторонами, или какие-то другие методы, мы не знаем. Но в нынешнем виде ИИ-генераторы изображений в текст остаются угрозой личным данным, которая будет только расти.