Vos données sont désormais un manuel pour l'IA et vous ne pourrez plus les récupérer

L'art imite la vie, nous le savons tous. Mais que se passe-t-il si l'art imite votre vie personnelle, votre ressemblance personnelle et le fait si bien que la frontière entre le réel et le surréel disparait peu à peu ?

À notre insu, nous devenons des modèles pour une technologie d'IA de pointe qui s'entraîne sur des téraoctets de données mal filtrées provenant de tout le web. Ces données peuvent inclure nos photos personnelles, des images médicales et même du contenu protégé par des droits d'auteur - en fait, tout ce qui est publié en ligne.

Les modèles d'apprentissage profond de conversion de texte en image comme DALLE-E 2, Midjourney et Stable Diffusion s'améliorent pour reconnaître, interpréter et réaffecter ces données. Lorsqu'ils reçoivent un texte, ils produisent des images détaillées basées sur ce qu'ils ont appris. Et si ces images ne sont pas encore parfaites, elles sont de plus en plus photoréalistes. Aussi invraisemblable que cela puisse paraître, il se peut qu'un jour un algorithme produise votre propre image - du moins, on ne peut l'exclure.

Il est vrai que les chances que tout cela arrive à une personne ordinaire sont faibles. Les personnalités publiques, en revanche, sont beaucoup plus susceptibles de voir leur image exploitée et utilisée pour tromper les crédules. L'IA s'est gavée de leurs données publiques et les connaît déjà en pleine figure. Il ne reste plus à un acteur malveillant qu'à trouver un texte astucieux.

Images Diffusion Stable d'Elon Musk dans un tableau de style Monet et de Bill Gates avec un fusil près d'une voiture. Image reproduite avec l'aimable autorisation de Stability AI.

Il n'existe actuellement aucun moyen d'éviter d'être emporté par le flux de données de l'IA. Vous ne pouvez retirer vos données de ce cours d'art improvisé que post-factum, c'est-à-dire après qu'elles aient déjà été utilisées comme échantillon d'entraînement pour l'IA. Pour cela, vous devez vous renseigner sur des sites tels que Have I Been Trained, vous assurer qu'elles répondent aux exigences, déposer une plainte et espérer que tout ira bien.

L'état actuel de la technologie : Impressionnant mais désordonné

Les générateurs d'images de l'IA sont les nouveaux venus dans le monde, ce qui explique en partie pourquoi ils ont jusqu'à présent échappé à la réglementation. L'un des outils les plus connus et les plus avancés pour créer des images à partir d'une description est DALL-E. Cet encodeur texte-image a été mis en vente en janvier dernier sur une liste d'attente et est devenu accessible au grand public en septembre dernier. Quelque 1,5 million de personnes ont déjà utilisé le service, "créant plus de 2 millions d'images par jour ", selon OpenAI, la société à l'origine de l'outil.

En plus d'une liste d'attente, OpenAI a abandonné les restrictions sur la modification des visages humains. Mais, contrairement à la plupart de ses concurrents, OpenAI a mis en place des garde-fous. Ainsi, OpenAI a déclaré avoir affiné l'algorithme de filtrage de l'IA pour bloquer les contenus sexuels, politiques, violents et haineux. La politique de DALLE-E interdit également aux utilisateurs de télécharger des "images de toute personne sans son consentement " et des images sur lesquelles les utilisateurs n'ont aucun droit.

Il ne semble pas y avoir de moyen pratique pour DALLE-E de faire respecter cette politique particulière, si ce n'est de prendre les utilisateurs au mot. Dans le but de minimiser les risques d'abus potentiels, les développeurs ont précédemment déclaré qu'ils avaient affiné le processus d'entraînement de DALL-E, "limitant " sa capacité à mémoriser les visages. Cela a été fait principalement pour que l'IA ne produise pas de sosies de personnalités publiques ou ne contribue pas à les placer dans un contexte trompeur. La politique de contenu d'OpenAI interdit spécifiquement les images de "politiciens, urnes, ou tout autre contenu pouvant être utilisé pour influencer le processus politique ou faire campagne " et met en garde contre les tentatives de création d'images de personnalités publiques. Des utilisateurs ont signalé que DALLE-E semble effectivement ne pas répondre aux invites mentionnant des célébrités et des hommes politiques.

Malgré son nom, le miracle texte-image d'OpenAI n'est pas open source, et il y a une bonne raison à cela. OpenAI fait valoir que "rendre les composants bruts du système librement disponibles laisse la porte ouverte aux mauvais acteurs qui pourraient les entraîner sur des contenus subjectivement inappropriés, comme la pornographie et la violence graphique."

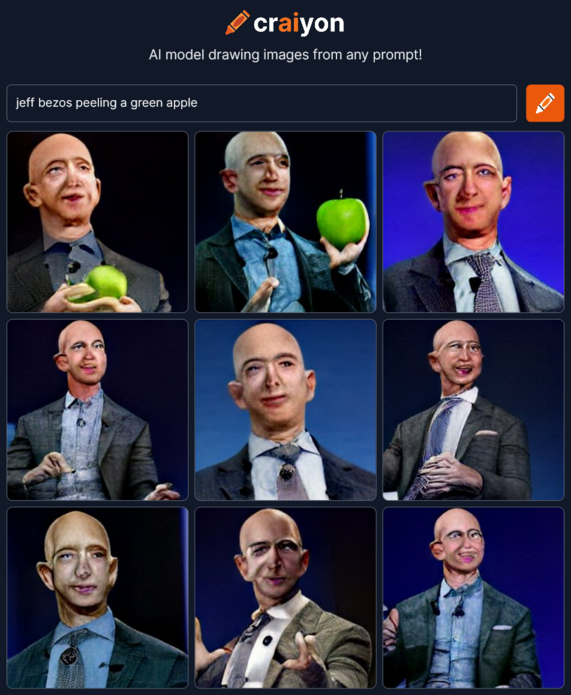

D'autres, cependant, ont repris le flambeau là où OpenAI l'avait laissé. Inspiré par DALL-E, un groupe de passionnés d'IA a créé Crayion (anciennement DALLE-E mini ), un générateur de texte-image gratuit et open-source. Mais comme il est entraîné sur un échantillon relativement petit de données non filtrées provenant d'Internet - environ 15 millions de paires d'images et du texte alternatif correspondant - les dessins qui en résultent, en particulier ceux des personnes, sont beaucoup moins réalistes.

Beaucoup plus avancé que Crayion et beaucoup moins restrictif que DALLE-E 2 est Stable Diffusion, un modèle open-source publié par la startup StabilityAI en août de cette année. Il permet de générer des images de personnalités publiques ainsi que celles de manifestations et d'accidents qui n'ont jamais eu lieu et peuvent potentiellement être utilisées dans des campagnes de désinformation.

Images de fumée s'échappant de la Maison Blanche et de protestations à Disneyland générées par Stable Diffusion. Image fournie par Stability AI.

Stable Diffusion vous donne l'autorisation de distribuer et de vendre votre production à condition que vous acceptiez une liste de règles. Par exemple, vous ne pouvez pas utiliser le modèle pour enfreindre la loi, nuire aux mineurs, diffuser de fausses informations "dans le but de nuire à autrui ", "générer ou diffuser des informations personnelles identifiables qui peuvent être utilisées pour nuire à un individu ", fournir des conseils médicaux, enfreindre les droits d'auteur, usurper l'identité d'individus ainsi que "diffamer, dénigrer ou harceler autrui de toute autre manière ". C'est apparemment aux personnes extérieures et aux victimes elles-mêmes qu'il incombe de signaler le contenu interdit.

Le fait que les modèles d'IA parviennent de mieux en mieux à imiter le toucher humain et à tromper de plus en plus les observateurs humains ne fait qu'aggraver (ou améliorer, selon le point de vue que l'on adopte) la situation. Une controverse a éclaté après qu'un artiste non professionnel a reçu le premier prix du concours d'art numérique de la foire d'État du Colorado de cette année pour son œuvre créée à l'aide de Midjourney, un autre outil d'IA de conversion de texte en image. Il n'y a pas si longtemps, un journaliste de The Atlantic a mis le feu aux poudres sur Twitter après avoir utilisé Midjourney pour concocter deux images du théoricien de la conspiration Alex Jones pour une newsletter.

Il y a fort à parier que les outils alimentés par l'IA s'amélioreront encore avec le temps. Les chercheurs à l'origine du modèle d'IA texte-image de Google, Imagen, affirment qu'il est déjà plus performant que la dernière version de DALLE-E - DALLE-E 2- en termes de précision et de qualité d'image.

Il y a beaucoup de spéculations et d'incertitudes sur la façon dont les synthétiseurs d'images alimentés par l'IA affecteront l'art et la réalité tels que nous les connaissons. Cela dépendra en grande partie de la capacité des développeurs à dompter leurs bêtes IA, mais aussi des données dont elles continueront à se régaler.

D'où viennent les données ?

Les modèles d'IA comme DALLE-E et Stable Diffusion s'entraînent sur des ensembles de données géants provenant de tout le Web.

Ainsi, DALLE-E 2 a reçu 650 millions de paires texte-image déjà disponibles sur Internet. Stability AI a été entraîné principalement sur le sous-ensemble anglais de l'ensemble de données LAION-5B. LAION 5B (Large-scale Artificial Intelligence Open Network) est un jeu de données open source contenant 5,6 milliards d'images extraites du Web, dont 2,3 milliards de paires image-texte en langue anglaise, ce qui en fait le plus grand jeu de données image-texte librement accessible au monde. Son prédécesseur, LAION-400, contient 413 millions de paires, et a été utilisé par Google pour former Imagen. Ce jeu de données a été initialement créé par des chercheurs dans le but de reproduire le jeu de données OpenAi, non ouvert au public.

LAION se décrit comme un organisme à but non lucratif dont la mission est de "démocratiser la recherche et l'expérimentation autour de la formation de modèles multimodaux à grande échelle ". Bien que la mission soit noble, elle a un coût élevé pour la vie privée. Les données que les chercheurs ont analysées pour trouver des paires image-texte proviennent de Common Crawl, une autre organisation à but non lucratif qui explore le web tous les mois et fournit gratuitement des pétaoctets de données au public. Dans ses conditions d'utilisation, Common Crawl déclare qu'il "a simplement trouvé les données sur le web " et "ne se porte pas garant du contenu et n'est pas responsable en cas de problème ".

Compte tenu de l'origine des données, il n'est pas surprenant que des informations personnelles identifiables (PII), des images sensibles et du contenu protégé par des droits d'auteur puissent se glisser dans l'ensemble de données. ArtTechnica a rapporté le mois dernier comment une artiste en IA a découvert ses propres photos médicales dans l'ensemble de données LAION-5B. Les photos avaient été prises par le médecin de l'artiste (aujourd'hui décédé) et étaient destinées uniquement à l'usage privé de ce médecin.

Il faut noter que LAION n'héberge pas les images, mais se contente de fournir les URL à partir desquelles elles peuvent être téléchargées. Ainsi, LAION ne peut vraisemblablement pas être tenu responsable de la diffusion de vos données personnelles ou de votre travail. Cela signifie également que, d'un point de vue juridique, nous nous heurtons à un mur en essayant de trouver les personnes coupables d'une éventuelle utilisation abusive des données. Un autre problème est qu'il n'y a aucun moyen de se retirer de l'apprentissage de l'IA, et que vous devez vous plier en quatre pour retirer vos données post-factum.

Comment supprimer vos données personnelles du flux d'IA ?

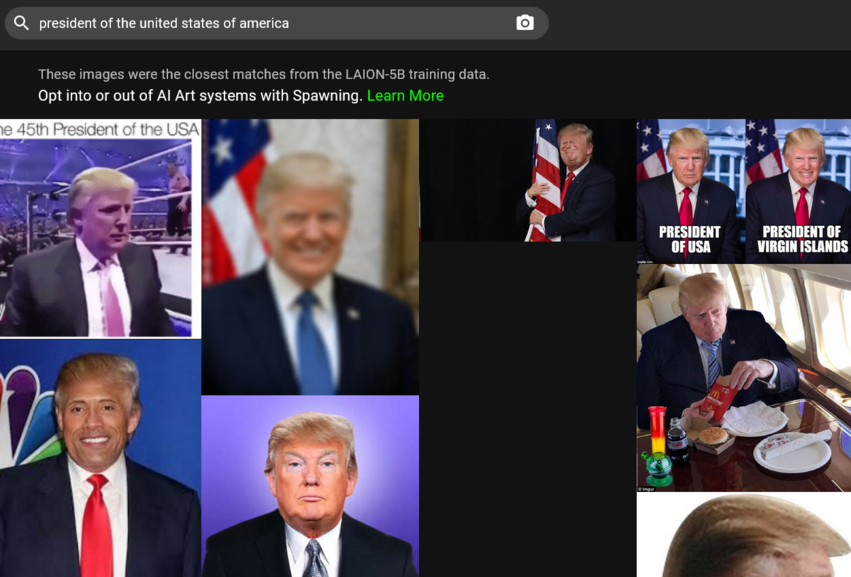

Tout d'abord, pour demander le retrait de vos images de l'ensemble de données d'entraînement de l'IA, vous devez les y trouver. La tâche peut sembler ardue étant donné qu'il y a des millions de paires image-texte à parcourir. Heureusement, il existe désormais un raccourci pour y parvenir. Le mois dernier, une société appelée Spawning AI a lancé Have I Been Trained ?, un site où vous pouvez effectuer des recherches dans la base de données LAION-5B en lui fournissant une image ou un texte. Vous pouvez également jouer avec l'algorithme (attention, vous risquez d'obtenir des résultats très curieux).

Si vous parvenez à retrouver votre image, vous devrez remplir un formulaire de retrait sur la page GDPR de LAION. LAION promet d'examiner le rapport et, s'il s'avère que l'image en question enfreint la législation européenne sur la protection des données, de la supprimer de tous les référentiels de données sous son contrôle et des futures versions.

Spawning met également au point des outils qui permettront aux artistes "d'accepter ou de refuser la formation de grands modèles d'intelligence artificielle " ainsi que "de définir des autorisations sur la manière dont leur style et leur image sont utilisés " Les utilisateurs peuvent demander un accès bêta à ces outils sur le site web de la société. Stable Diffusion, qui soutient les efforts de Spawning, déclare qu'elle va construire "un système d'opt-in et d'opt-out pour les artistes et autres personnes que les services peuvent utiliser en partenariat avec les principales organisations ".

DALLE-E permet aux personnes qui constatent que leur travail a été utilisé sans leur consentement de signaler la violation à l'OpenAI mail. Quant à la mère des dragons, la source originale d'une grande partie des données - Common Crawl - elle ne semble indiquer qu'une boîte postale à laquelle vous pouvez signaler une violation du droit d'auteur.

En résumé, nous sommes largement laissés à nous-mêmes lorsqu'il s'agit de s'assurer que nos données ne sont pas aspirées par l'IA. Cela s'explique en partie par l'énigme juridique que représente le fait que chaque partie ne revendique aucune responsabilité pour le résultat final. En partie, c'est la façon dont Internet fonctionne - il n'oublie jamais.

L'IA va-t-elle produire votre sosie exact et peut-elle "désapprendre" votre apparence ?

Comme en témoigne l'exemple des personnalités publiques, l'IA, avec un entraînement suffisant, peut générer des images reconnaissables de personnes réelles. Techniquement, rien n'empêche l'IA de faire le même tour avec votre ressemblance.

OpenAI concède que, bien que DALLE-E 2 ne puisse pas "générer littéralement des images exactes de personnes, il peut être possible de générer une ressemblance avec une personne dans les données d'entraînement " Il en va probablement de même pour d'autres modèles d'IA. Des recherches ont montré que les images générées par une autre catégorie de modèles d'apprentissage profond - les réseaux adversariaux génératifs (Generative Adversarial Networks)

(GAN) - ressemblent effectivement à des personnes réelles. Dans l'article intitulé This Person (Probably) Exists. Identity Membership Attacks Against GAN Generated Faces, les chercheurs ont montré qu'il était possible de réidentifier les identités sources qui contribuaient à générer des images de "personnes inexistantes."

"Alors que certains échantillons ne présentent qu'une simple ressemblance, d'autres images générées partagent fortement les caractéristiques idiosyncrasiques des identités d'apprentissage", ont constaté les chercheurs.

Quant à savoir s'il est possible pour les modèles d'IA de supprimer ce qu'ils ont déjà appris sur vous, le PDG de Stability AI, Emad Mostaque, a déclaré à Ars Technica que c'était possible, mais que cela nécessitait quelques ajustements ou du travail supplémentaire. La grande question est de savoir si les développeurs sont prêts à se donner beaucoup de mal pour le faire - car ils n'y sont pas obligés.

Résoudre le problème de l'IA. Mission impossible?

Il est évident que les résultats obtenus par ces pionniers de l'IA sont admirables. Le fait que certains d'entre eux rendent le code open-source et, dans le cas de Stability AI, le publient sous une licence permissive qui n'interdit pas l'utilisation commerciale, aidera les chercheurs, les créateurs et les progrès.

Cependant, cela peut aussi se retourner contre eux, car il est extrêmement difficile d'empêcher les mauvais acteurs d'utiliser le modèle du code source ouvert. Le plus important, peut-être, est qu'il n'existe actuellement aucun moyen pour les artistes et les personnes ordinaires d'éviter de faire partie d'un produit final généré par l'IA. En outre, même si nous voulons retirer nos images des données d'entraînement, nous devons compter sur la bonne volonté des entreprises.

Ces questions toucheront d'autant plus de personnes que ces technologies se généraliseront. Ainsi, Microsoft a récemment annoncé qu'elle intégrait deux de ses applications à DALL-E 2. L'une de ces applications est Image Creator, qui sera disponible gratuitement dans le moteur de recherche Microsoft Bing et dans Edge.

La situation appelle une réglementation. Nous ne savons pas s'il s'agit d'une conservation minutieuse des ensembles de données, d'un mécanisme d'exclusion clair et respecté par toutes les parties, ou d'autres méthodes d'atténuation. Mais en l'état actuel des choses, les générateurs d'images en texte de l'IA restent une menace pour la vie privée, qui ne fera que croître.