Les assistants vocaux et vos secrets : leur faites-vous vraiment confiance ?

Google ou Amazon, Apple ou Microsoft, les géants de la tech peuvent collecter beaucoup de données et les divulguer, nous le savons tous. Mais nous ne sommes pas prêts à cesser d'utiliser leurs produits. Les assistants vocaux en font partie.

Demandez à Siri de vous raconter une blague ou une histoire au coucher et vous ne vous sentirez plus seul ou ennuyé. Si vous n'arrivez pas à prendre une décision, demandez-lui de tirer à pile ou face. Ou bien ajoutez un peu de magie et utilisez des sorts de Harry Potter au lieu de commandes. Et pour certaines personnes, les assistants vocaux facilitent considérablement la vie : par exemple, pour ceux qui ont des problèmes de vue.

Les assistants vocaux, en effet, contribuent largement à notre confort. Lorsque vous conduisez votre voiture, vous pouvez gérer les appels téléphoniques, les messages, la navigation, les actualités, les réservations, etc. en gardant les mains libres - vous devenez fantastique en matière de multitâche. Dans les maisons intelligentes, vous pouvez demander à votre assistant d'ouvrir la porte ou d'allumer la lumière. Vous pouvez créer des textes plus efficacement en les dictant. Et vous pouvez parler à des étrangers sans connaître leur propre langue.

Mais la commodité a son revers, et les assistants vocaux sont un sujet plutôt sensible. Soit vous êtes enthousiasmé par eux, soit vous les craignez et essayez de les éviter à tout prix. Et il y a des raisons à cela. Les grandes entreprises technologiques ne se concentrent pas principalement sur les assistants vocaux, si bien que les questions de protection des données sont souvent négligées.

Problème #1: les données sont traitées dans le cloud

Il existe plusieurs façons dont les assistants vocaux fonctionnent.

Certains d'entre eux enregistrent et compriment les données audio, puis les envoient vers les serveurs de l'entreprise, où elles sont traitées. Le résultat - la "réponse" - est renvoyé à votre téléphone ou à tout autre appareil doté de la technologie de l'assistant vocal, qui utilise un système de synthèse vocale local pour créer l'impression d'un dialogue cohérent.

Dans ce cas, ce sont les données vocales qui sont sauvegardées sur le cloud - et c'était la seule option jusqu'à récemment : auparavant, l'interprétation précise des commandes vocales nécessitait une puissance de calcul bien supérieure à celle que pouvait contenir un seul appareil. Et en utilisant le traitement de la parole dans le cloud, on pouvait faire plus avec moins de ressources.

Mais fin 2021, après plusieurs scandales de fuites de données et d'erreurs cruciales, la plupart des grandes entreprises technologiques - telles que Google, Amazon, Microsoft, Apple ou Samsung - avaient mis à jour leurs politiques de confidentialité ainsi que les technologies qu'elles utilisent. Désormais, la plupart d'entre elles utilisent, au moins partiellement, le traitement de la parole sur les appareils. Cela aurait pu apaiser certaines craintes liées à la vie privée : si votre voix ne quitte pas votre appareil, personne ne saura comment elle sonne et ne l'utilisera à son profit. Mais en fait, cela n'a guère changé la situation.

Les données sont toujours collectées - mais dans un format texte. Après avoir traité les données vocales localement, les appareils envoient les transcriptions aux serveurs pour pouvoir "comprendre" ce que vous avez dit et répondre.

Et ce n'est que pour une petite partie des commandes - comme "mettre le réveil à 7 heures" ou "appeler maman" - que la connexion internet n'est pas nécessaire. Les transcriptions ne sont envoyées nulle part, tout se fait localement sur votre appareil.

Ok, alors où est le problème ?

Le problème, c'est le cloud lui-même. Les données sont sécurisées (du moins plus sécurisées) lorsqu'elles sont stockées localement : personne d'autre que vous n'y a accès, alors que beaucoup plus de personnes peuvent accéder au nuage.

Dans un cas rare où quelqu'un s'introduit dans votre appareil, il n'aura accès qu'à vos données. Mais si les données sont stockées dans le nuage, les informations de millions d'utilisateurs peuvent être exposées à la suite d'une fuite ou d'une attaque.

Des fautes qui peuvent être fatales

Si vous n'avez pas désactivé la fonction "réagir à un mot de réveil", les assistants vocaux seront constamment à l'écoute. Ils ont besoin de ce mot de réveil pour commencer à interagir - ils sont donc toujours dans une sorte de "mode d'attente". Hé, Siri ! Ou c'était "city" ? Ou juste un son de fermeture éclair ?. On ne compte plus les cas où les assistants vocaux ont interprété par erreur des phrases aléatoires comme des mots de réveil : dans une émission de télévision en arrière-plan, dans une conversation amicale, dans une déclaration d'un député britannique aux Communes... Tout ce qui est dit après le mot d'éveil est considéré comme un ordre. Même si vous n'aviez pas voulu parler, votre assistant vocal vous écoutera.

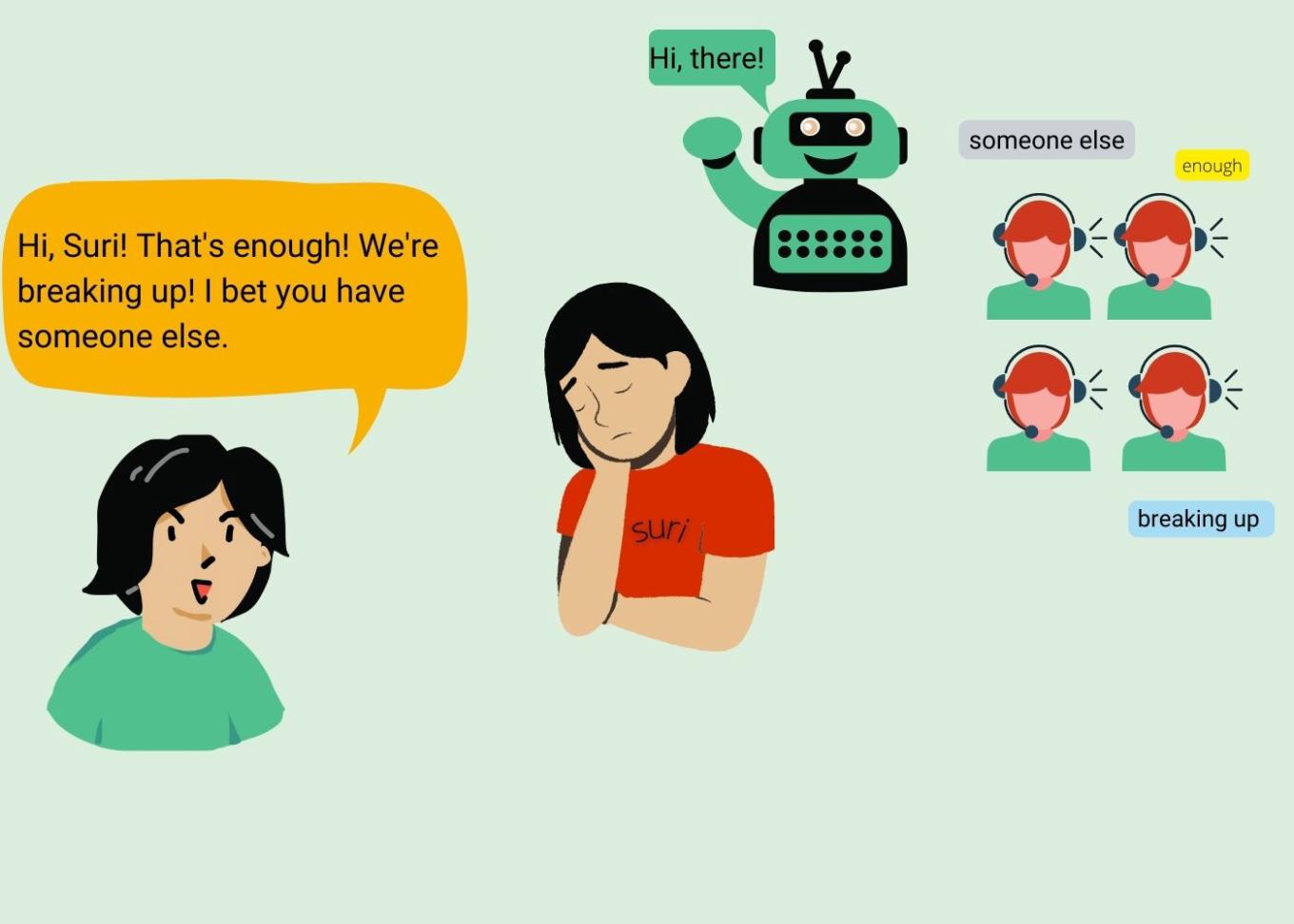

Problème #2 : les entreprises laissent des gens écouter vos conversations.

Si vous autorisez votre assistant vocal à écouter, il n'est pas le seul à être dans le coup. Pour analyser la précision des réponses des assistants vocaux, dit-on, les entreprises s'associent à des experts linguistiques qui écoutent certains des enregistrements de vos conversations avec les assistants.

Oui, ils ne le font qu'avec votre accord. Oui, ils ne prélèvent qu'un petit pourcentage de ce qui est enregistré. Oui, les informations sont rendues anonymes. Mais tout d'abord, si vous vous en souvenez bien, des erreurs peuvent se produire. Nous avons écrit précédemment sur Apple qui continuait à enregistrer vos données audio même si vous aviez dit non. En outre, il a été signalé que quelque 1 000 séquences de mots peuvent être interprétées à tort comme des mots déclencheurs par des assistants vocaux. Les enregistrements écoutés peuvent contenir toutes les informations imaginables : disputes familiales, conversations entre médecins et patients, transactions commerciales, trafic de drogue, relations sexuelles entre couples etc..

Deuxièmement, les informations ne sont anonymes que dans la mesure minimale requise par la loi. Ces enregistrements sont accompagnés de données de l'utilisateur indiquant sa localisation, ses coordonnées et les données de l'application.

Et outre le fait que cela suffit déjà à rendre un utilisateur vulnérable, le fait que des étrangers écoutent des conversations privées pourrait violer, par exemple, les conventions médicales en rompant la confidentialité. Imaginez : vous êtes médecin. Vous avez choisi de ne pas enregistrer vos données vocales pour améliorer votre assistant vocal. Mais il y a eu un bogue dans le système - et la conversation avec votre patient a quand même été enregistrée. Et figurait parmi les enregistrements examinés par des travailleurs humains. Ou peut-être avez-vous dit oui parce que vous vous attendiez à ce que votre assistant vocal n'enregistre que vos interactions avec lui, rien de plus - mais l'assistant a mal compris un mot et a commencé à enregistrer. Qui a violé la confidentialité dans ce cas et comment auriez-vous pu l'éviter ? Avec toutes ces erreurs, il semble que vous ne pouvez pas dire avec certitude si les informations que vous partagez dans une conversation sont sécurisées - parce que vous avez un assistant vocal installé sur votre téléphone.

Problème #3: S'ils le veulent, ils en sauront encore plus - et pas seulement eux

Même si vos enregistrements n'avaient pas figuré parmi cette petite partie des données analysées, ils sont toujours sur les serveurs. Apple stocke les transcriptions de ce que vous dictez, sauf indication contraire. Microsoft s'autorise à accéder aux transcriptions de votre voix sans votre consentement. Amazon stocke une grande quantité d'informations audio : il n'y a pas si longtemps, une utilisatrice de Twitter a publié une photo de la quantité de données qu'Alexa avait sur elle. Un journaliste de Reuters a découvert que en quatre ans, Alexa d'Amazon avait effectué plus de 90 000 enregistrements de lui et des membres de sa famille. (P.S. Si vous voulez savoir comment demander ces informations, voici une instruction d'Amazon.

Et si les sons accidentels n'ont pas une grande valeur commerciale, les enregistrements de vos conversations réelles avec les assistants vocaux en ont une. Toutes les entreprises sont désireuses de connaître vos centres d'intérêt, mais certaines le sont plus que d'autres. Ce que vous recherchez, ce que vous achetez, les chaînes que vous regardez, les personnes avec qui vous passez votre temps, etc. - tout cela constitue des données monétisables, peut-être trop savoureuses pour que ceux qui recherchent vos données puissent résister à la tentation.

En outre, d'autres parties s'intéressent également à votre personnalité : les pirates informatiques et le FBI (et certains pirates informatiques déguisés en policiers pourraient demander et voler des données d'utilisateur même à Apple et Meta). Les données personnelles peuvent faire l'objet de fuites, elles peuvent être demandées par l'appareil de surveillance de l'État, et les données recueillies par les assistants vocaux peuvent être extrêmement sensibles.

En ce qui concerne les fuites de données, on dit qu'Amazon a accumulé tellement de données qu'il a du mal à en garder la trace : selon des sources internes à l'entreprise, Amazon ne savait pas où les données des utilisateurs étaient stockées et n'était donc pas en mesure d'identifier les fuites de données potentielles. Et si vous ne savez pas où se trouve quelque chose, cela peut facilement vous glisser entre les doigts.

Problème #4: tout ne peut pas être supprimé

Amazon ne pouvait pas non plus s'assurer, disent-ils, que la suppression des données demandée par les utilisateurs aboutissait effectivement. Techniquement, il existe une possibilité de demander les journaux de vos interactions avec les assistants vocaux et de demander à l'entreprise de les supprimer. Cela est valable dans la plupart des cas, notamment pour Alexa, Cortana et Google Assistant. Quant à Siri, Apple ne vous fournira pas les journaux et ne supprimera que les données datant de moins de six mois - passé ce délai, les données audio ou les transcriptions perdront leur identifiant unique et pourront être utilisées à des fins d'amélioration. Mais vos données seront-elles vraiment supprimées ?

Si vous demandez au fournisseur les journaux de vos interactions avec les assistants vocaux, vous pouvez - théoriquement - vous attendre à ce que la société supprime la file d'attente des demandes traitées, qui est liée à votre identifiant et donc à vous. Cependant, de l'autre côté de votre demande - du côté du traitement - il y a un système d'information qui aura toujours quelque chose sur vous. Il stocke (au moins) les journaux d'exécution des demandes : demandes adressées à un moteur de recherche, à un service musical, à un service de produits, etc.

En outre, les entreprises ont tendance à collecter des statistiques sur les demandes des utilisateurs. Elles stockent des mesures pour déterminer ce qui intéresse les gens - ce qui est le plus fréquemment recherché, quels services sont préférés, quelle musique est écoutée. Vous vous souvenez de "Year in Search" de Google ? Il s'agit de données agrégées, mais elles ne sont pas si anodines. Bien que les données soient détachées d'une personne spécifique et de son identifiant, les requêtes adressées aux assistants vocaux peuvent contenir des noms complets, des adresses, des professions, etc. Les transcriptions ont été supprimées ? Mais le fait que quelqu'un ait commandé un taxi d'un bar à votre adresse chaque vendredi demeure.

Nous ne pouvons pas être sûrs à 100% que la société supprimera tout si nous le demandons. Nous ne pouvons pas non plus le prouver. La morale ici est la même que d'habitude : c'est notre choix de leur faire confiance ou non.

Vous pouvez contôler vos données

Les entreprises ne renonceront pas facilement à collecter des informations sur vous. Plus elles en savent, plus elles gagnent de l'argent en vendant ces informations aux annonceurs. Plus votre profil est précis, plus il est facile de vous accrocher. Inutile de dire qu'ils ne vont pas commencer à coopérer par hasard. Et le mieux que l'on puisse faire est d'être conscient des risques.

Vous ne devez pas jeter tous vos appareils électroniques à la poubelle, mais plutôt savoir comment atténuer ces risques. Vous pouvez demander vos données, demander aux entreprises de les supprimer, désactiver les assistants vocaux dans les conversations privées et demander à vos amis de faire de même.

Vous pouvez également souhaiter que votre appareil vous alerte lorsqu'il écoute activement ce que vous dites (https://www.youtube.com/watch?v=eWvWmCHy0oM). Assurez-vous d'avoir un mot de passe fort qui n'est pas réutilisé sur vos autres appareils et une authentification à deux facteurs en place. Si vous avez un enfant, mettez en place un code PIN ou désactivez les achats vocaux, à moins que vous ne vouliez que votre enfant de 4 ans commande une avalanche de jouets. Si vous voulez aller plus loin, vous pouvez couper le microphone de votre assistant vocal - dans ce cas, il ne s'activera pas au réveil et devra être activé manuellement à chaque fois.

D'un autre côté, vous pourriez vouloir garder le micro allumé tout le temps, qui sait, votre assistant vocal pourrait vous fournir un alibi un jour.

En outre, vous pouvez étudier attentivement les politiques de confidentialité des entreprises et choisir celle qui répond le mieux à vos besoins : peut-être celle qui indique explicitement qu'elle ne partage pas vos données avec des tiers. Ou celle qui ne stocke pas les informations sur les serveurs. Vous pouvez également lire des critiques et des enquêtes pour savoir si l'entreprise à laquelle vous envisagez de confier vos informations personnelles a été prise en flagrant délit de fuite de données.

Dans tous les cas, vous ne pouvez pas éliminer tous les risques pour votre vie privée lorsque vous utilisez des assistants vocaux. La meilleure chose à faire est de peser le pour et le contre et de décider par vous-même si vous avez vraiment besoin de l'aide d'un assistant vocal. Quelle que soit votre décision, un choix judicieux sera toujours la meilleure option.