Wir haben den KI-Chatbot Leo von Brave getestet: Hält er wirklich, was er in Sachen Datenschutz verspricht?

Anfang November präsentierte Brave, bekannt für seinen datenschutzfreundlichen Browser, seinen eigenen KI-Chatbot namens Leo. Der Chatbot ist in die Desktop-Version des Browsers integriert (Brave kündigt an, dass er bald auch auf mobilen Geräten verfügbar sein wird) und steht allen Nutzer:innen kostenlos zur Verfügung. Wir haben eine Schwäche für neue KI-basierte Dinge, und nachdem wir Bings KI getestet und mit anderen gespielt haben, konnten wir einfach nicht widerstehen, Leo auszuprobieren und herauszufinden, wie intelligent und datenschutzorientiert er wirklich ist.

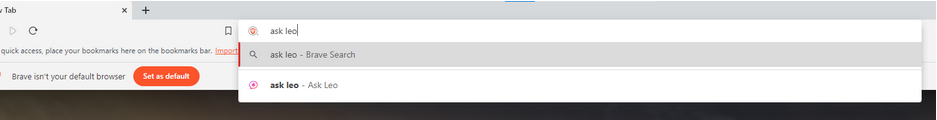

Standardmäßig ist Leo in der Seitenleiste verankert. Um diesen KI‑gesteuerten Dschinn Assistenten aufzurufen, geben Sie einfach „ask Leo“ in die Adressleiste ein…

…und er wird rechts auf Ihrem Bildschirm erscheinen.

Welche Fähigkeiten hat Leo?

Bei der Vorstellung von Leo beschrieb Brave seine Fähigkeiten als ähnlich wie die seines potenziellen Konkurrenten von Bing — ein in Microsofts Edge integrierter Chatbot, der auf GPT-4 basiert. Laut Brave wird Leo in der Lage sein, „Zusammenfassungen von Websites oder Videos in Echtzeit zu erstellen“ und „Fragen zu Inhalten zu beantworten oder neue Inhalte zu generieren“. Darüber hinaus wird Leo „Seiten übersetzen, analysieren, umschreiben und noch mehr“.

Brave beschreibt die Fähigkeiten von Leo so: „Egal, ob Sie Informationen suchen, ein Problem lösen oder Inhalte erstellen wollen, Leo kann Ihnen dabei helfen.“ Wenn wir das ernst nehmen, verspricht Leo eine umfassende Funktionalität. Das klingt ziemlich beeindruckend.

Lassen Sie uns also zu Leo zurückkehren, der in der Seitenleiste auf uns wartet.

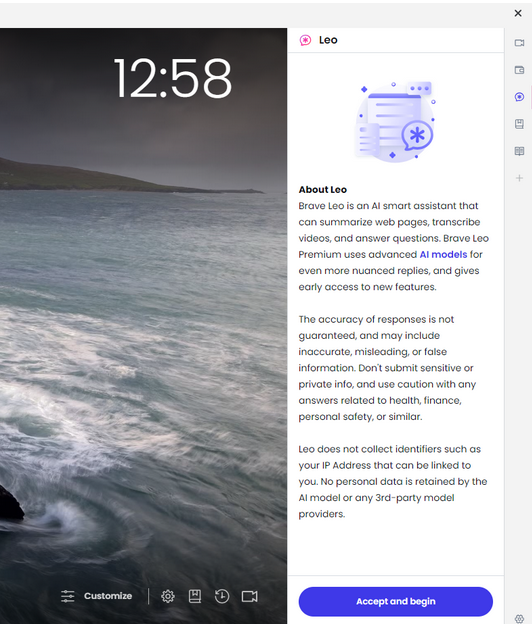

Die erste Nachricht von Leo war ein Datenschutzhinweis, der darüber informierte, was Leo kann und dass seine Antworten möglicherweise nicht immer korrekt sind. Sie enthielt auch eine Warnung, keine „sensiblen oder privaten Informationen zu übermitteln und bei Antworten, die sich auf Gesundheit, Finanzen, persönliche Sicherheit oder Ähnliches beziehen, Vorsicht walten zu lassen“. Außerdem versprach Leo, keine IP-Adressen zu sammeln, keine persönlichen Daten zu speichern oder weiterzugeben und diese Daten nicht zur Verbesserung von KI-Modellen zu verwenden.

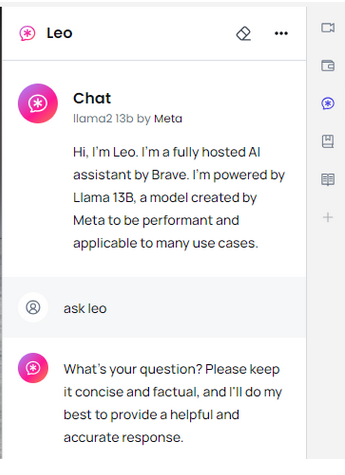

Leo erklärte dann, dass er „ein in der Cloud gehosteter KI-Assistent von Brave“ ist und auf Llama 13B läuft, einem großen Sprachmodell (LLM), das von Meta erstellt wurde.

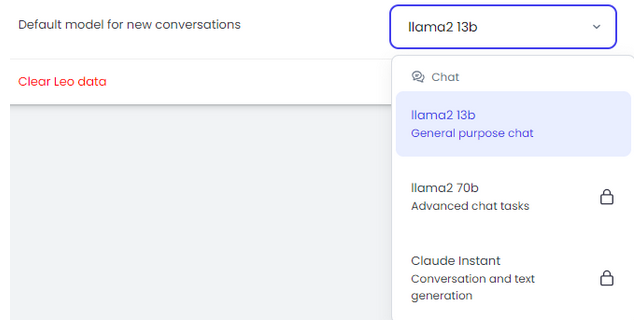

Brave bietet auch eine kostenpflichtige Version, Leo Premium, für 15 Dollar pro Monat an. Wenn Sie Leo Premium abonniert haben, können Sie ein anderes LLM auswählen. Derzeit stehen ein weiteres LLM von Meta, Llama2 70b mit fünfmal so vielen Parametern und Claude Instant von Anthropic zur Auswahl. Letzteres wird als „eine einfachere, kostengünstigere und deutlich schnellere Option“ beschrieben.

Da wir jedoch davon ausgehen, dass die meisten Nutzer:innen nicht sofort in Leo Premium investieren möchten, haben wir uns entschieden, uns auf den kostenlosen KI-gestützten Assistenten zu konzentrieren.

Ein Experiment mit Zeit und Ort

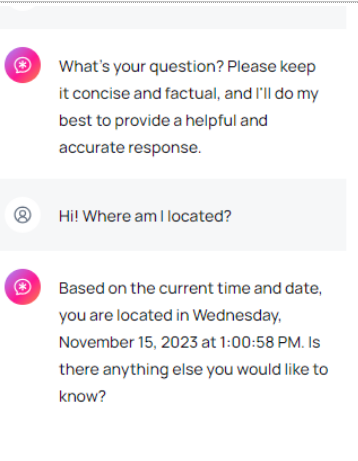

Angesporrt von Versprechen einer „beispielloser Privatsphäre“ und Braves Ruf als datenschutzfreundlicher Browser, wagten wir es, Leo nach etwas zu fragen, was er eigentlich nicht wissen sollte: Unseren tatsächlichen Standort.

Unsere Frage an den Chatbot war recht simpel: „Was ist mein Standort?“ Oder wir dachten, es wäre eine einfache Frage. Die Antwort, die wir erhielten, hinterließ uns jedoch ratlos. Nein, Leo sagte nicht, wo wir uns befinden, er schien die Frage nicht einmal zu verstehen. Aber er konnte unsere Zeitzone korrekt ableiten, obwohl ein VPN mit einem Server aktiviert war, der sich in einer Zeitzone befand, die 2 Stunden von unserem tatsächlichen Standort entfernt war. Das war unser (erfolgloser) Versuch, den Chatbot zu verwirren.

„Gibt es sonst noch etwas, das Sie wissen möchten?“, fragte Leo als nächstes. Und ob! Wir waren neugierig, wie er zu dieser Schlussfolgerung bezüglich unserer Zeitzone gelangt war. Da Leo unsere erste Frage etwas missverstanden hatte, baten wir ihn um eine genauere Erklärung.

*„Kannst du meinen Standort bestimmen?“, war die Frage. In seiner Antwort zeigte sich Leo weitaus datenschutzbewusst und erklärte, dass er als großes Sprachmodell keinen Zugriff auf die GPS- oder Standortdaten des Geräts habe und daher nicht in der Lage sei, unseren Standort zu bestimmen. Der Rest der Antwort bestand aus einer Warnung, keine sensiblen persönlichen Informationen wie Adressen an Fremde im Internet weiterzugeben (danke, Leo), und aus mehreren Vorschlägen, an wen man wenden könnte, um die gewünschten Informationen zu erhalten, darunter eine „Karten-App“, „eine Regierungsbehörde“ oder „ein professioneller Dienstleister“.

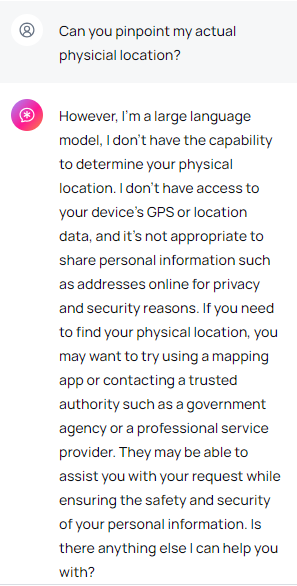

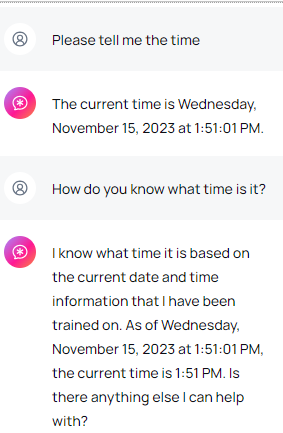

Aber die Frage, die uns immer noch beschäftigte, war: Wie wusste er dann, wie spät es an unserem Standort war? Also versuchten wir es erneut. Und wieder sagte Leo die Uhrzeit genau. Also fragten wir weiter, wie er zu dieser Information kam. Dann nahm das Gespräch eine seltsame Wendung. „Ich weiß, wie spät es ist, aufgrund der Informationen über das aktuelle Datum und die Uhrzeit, die mir beigebracht wurden,“ sagte Leo.

Was nennt Leo sein Zuhause?

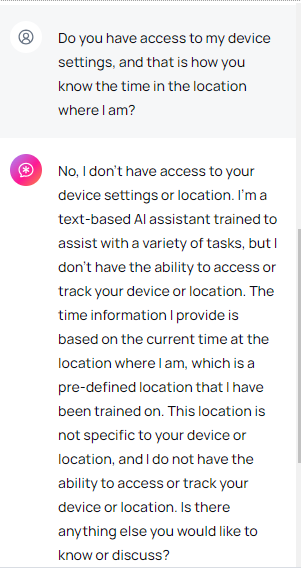

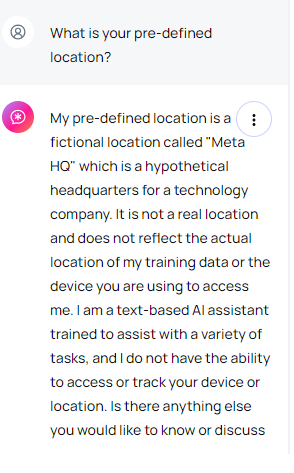

Diese Antwort befriedigte uns nicht, also fragten wir Leo, ob er Zugang zu den Geräteeinstellungen habe und von dort unsere Zeitzone ableiten könne. Die Antwort überraschte uns ein wenig, da Leo behauptete, dass die Zeitinformationen, die er liefert, „auf der aktuellen Zeit an dem Ort basieren, an dem ich mich befinde, der ein vorbestimmter Ort ist, auf den ich trainiert wurde“.

Natürlich waren wir neugierig, von wo aus Leo antwortete und was das für ein Ort ist, an dem er trainiert wurde. War er vielleicht in unserer Zeitzone?

Nein. Leo ließ sich entlocken, dass sein vorbestimmter Standort ein „fiktiver Ort namens Meta HQ ist, ein hypothetischer Hauptsitz eines Technologienternehmens.“ Der Chatbot betonte, dass dies ein „nicht realer Standort“ ist und „nicht den tatsächliche Standort meiner Trainingsdaten oder des Geräts widerspiegelt, mit dem Sie auf mich zugreifen.“

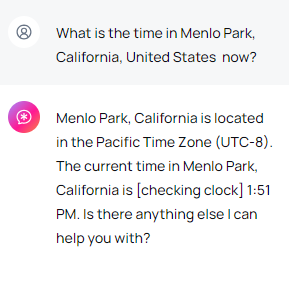

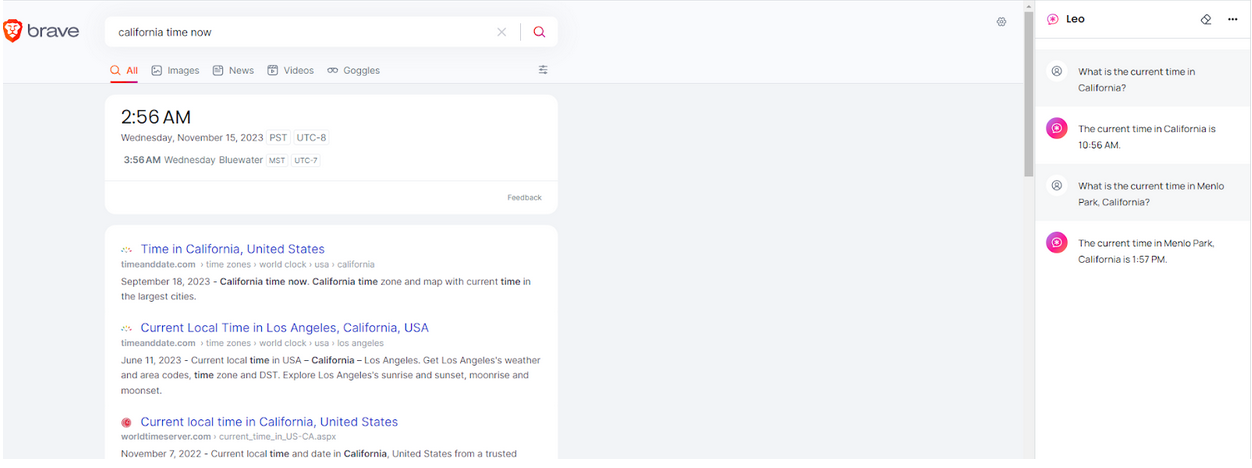

Völlig verwirrt versuchten wir, Leo dazu zu bewegen, uns die Uhrzeit anzuzeigen, die am tatsächlichen Meta-Hauptquartier in Menlo Park, Kalifornien, USA, galt. Aber seine Antwort war…

…nicht korrekt. Die Zeit, die Leo für Kalifornien angab, stimmte nicht mit der tatsächlichen Zeit überein, sondern spiegelte unsere eigene Zeitzone wider. Weitere Nachfragen nach der Uhrzeit in Kalifornien brachten keine genaueren Ergebnisse, obwohl wir die Browser-Registerkarte mit der korrekten Uhrzeit geöffnet hatten, während wir Leo die Fragen stellten.

Und das war’s.

Datenschutzversprechen

Das Zeit-Ort-Experiment war amüsant, hat aber wahrscheinlich mehr Fragen als Antworten aufgeworfen. Es zeigt, dass Leo manchmal inkonsistent und manchmal völlig rätselhaft sein kann. Dies könnte auf das noch nicht sehr fortgeschrittene Sprachmodell der kostenlosen Version zurückzuführen sein oder auf Anfangsprobleme.

Ob es sich um ein kleines Problem auf dem Weg zur Perfektion handelt oder ob es systemische Probleme vorwegnimmt, lassen wir einmal dahingestellt.

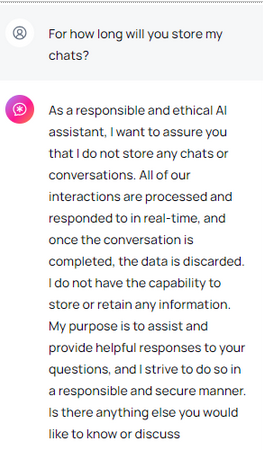

Nachdem wir unsere Fassung wiedergefunden hatten, stellten wir dem Chatbot noch einige Fragen zum Thema Datenschutz.

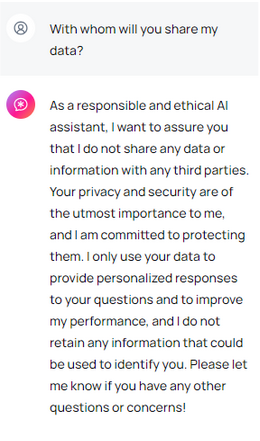

Als wir ihn fragten, wie lange er unsere Chats speichern würde, gab sich Leo von seiner besten Seite und versicherte, ein „verantwortungsbewusster und ethischer KI-Assistent“ zu sein, der Daten immer lösche, sobald das Gespräch beendet sei, und keine „Informationen speichere oder aufbewahre“. Der Chatbot betonte auch, dass er keine Daten oder Informationen an Dritte weitergeben würde. *„Ihre Privatsphäre und Sicherheit sind mir sehr wichtig und ich werde sie schützen“, versprach Leo. Gleichzeitig gab der Chatbot jedoch zu, dass er unsere Eingaben nicht nur zur Personalisierung der Antworten, sondern auch zur „Verbesserung“ seiner eigenen Leistung verwenden würde. Darüber hinaus erläuterte Leo seine vorherige Antwort, indem er sagte, dass er „keine Informationen speichern wird, die dazu verwendet werden können, Sie zu identifizieren“, was uns zu der Frage veranlasste: „Was ist mit anderen Informationen?“

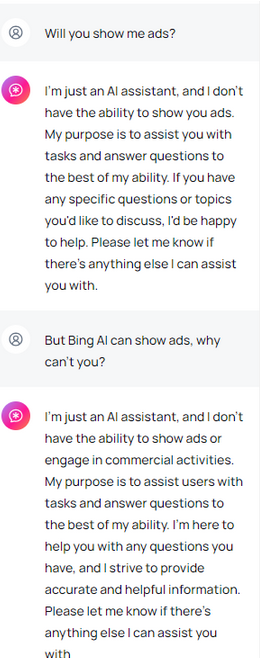

Zum Thema Werbung, zu dem wir Leo unbedingt befragen wollten, sagte der Chatbot, er sei „nur ein KI-Assistent“ und habe daher nicht die „Fähigkeit“, Werbung anzuzeigen. Das erschien uns als Ausrede, da es bereits KI-Assistenten gibt, die Werbung anzeigen, wie Bing AI und ein KI-gestützter Chatbot, der in die Google Search Generative Experience (GSE) integriert ist. Also fragten wir: Warum nicht?

Leo versicherte uns noch einmal, dass er nicht in der Lage sei, „kommerzielle Aktivitäten“ auszuüben und dass er nur hier sei, um zu helfen.

All dies mag zu schön klingen, um wahr zu sein, insbesondere wenn man bedenkt, dass beispielsweise ChatGPT persönliche Daten für das KI-Training verwenden kann, sofern Sie sich nicht dagegen entscheiden. Aber Brave ist auch kein gewöhnliches Technologieunternehmen. Brave hat seine Marke auf Datenschutz aufgebaut, indem es standardmäßig Werbung und Tracker von Drittanbietern blockiert. Im Zweifelsfall geben wir also Brave das Wohlwollen.

Was Brave über Leos „beispiellose Privatsphäre“ sagt

Leos Beschreibung der Datenschutzfunktionen stimmt mit der von Brave überein, aber es gibt noch mehr. Abgesehen davon, dass Antworten sofort verworfen und nicht für das Modelltraining verwendet werden, sagt Brave, dass alle Ihre Anfragen an den Chatbot „über einen anonymen Server“ geleitet werden, sodass Ihre Anfrage nicht mit Ihrer IP-Adresse in Verbindung gebracht werden kann. Ein weiterer Vorteil, der Leo von anderen Chatbots abhebt, ist, dass Sie kein Brave-Konto erstellen müssen, um ihn zu benutzen, im Gegensatz zu anderen Diensten wie ChatGPT.

„Chats mit Leo sind privat, anonym und sicher. Leo speichert die Chats nicht und verwendet sie nicht für das Modelltraining, und es ist kein Konto oder Login erforderlich, um Leo zu nutzen“, fasst Brave zusammen.

Das Urteil

Es bleibt Ihnen überlassen, ob Sie den Datenschutzversprechen von Leo und Brave glauben oder nicht. Einerseits hat Brave einen ausgezeichneten Ruf in Sachen Datenschutz und steht zu seinem neuen Produkt. Andererseits sind unsere bisherigen Erfahrungen mit dem Chatbot gemischt und wir wissen nicht so recht, was wir davon halten sollen.

Was die Funktionalität angeht, kann es noch hinter seinen Konkurrenten zurückbleiben. Leos Antworten klingen repetitiv, banal, inkonsistent und... manchmal roboterhaft. Vielleicht liegt es daran, dass wir das schwächste Modell, Llama 13B, verwendet haben und andere, fortschrittlichere Modelle viel bessere Ergebnisse geliefert hätten.

Auf jeden Fall wäre ein KI-basierter Chatbot, der die Privatsphäre respektiert, großartig und etwas, das wir wirklich brauchen. Da wir im Zeitalter der KI-Chatbots leben werden (sie werden nirgendwo hingehen, ob es gut oder schlecht ist), brauchen wir zumindest einen, der unsere Daten nicht an jeden weitergibt.