Ihre persönlichen Daten sind zu einem Trainingstool für KI geworden (unwiderruflich)

Kunst ahmt das Leben nach, das wissen wir. Aber was ist, wenn die Kunst Ihr persönliches Leben, Ihr persönliches Abbild imitiert, und zwar so gut, dass die Grenze zwischen dem, was real und surreal ist, verschwimmt?

Unbemerkt von uns werden wir zu Modellen für hochmoderne KI-Technologien, die auf Terabytes von schlecht gefilterten Daten trainieren, die aus dem gesamten Internet stammen. Diese Daten können unsere persönlichen Fotos, medizinische Bilder und sogar urheberrechtlich geschützte Inhalte enthalten — im Grunde alles, was jemals online veröffentlicht wurde.

Auf Deep Learning basierende Text-Bild-Modelle wie DALLE-E 2, Midjourney und Stable Diffusion werden immer besser im Erkennen, Interpretieren und Wiederverwenden dieser Daten. Wenn sie eine Textaufforderung erhalten, entwerfen sie auf der Grundlage des erworbenen Wissens detaillierte Bilder. Und obwohl diese Bilder noch nicht perfekt sind, werden sie immer fotorealistischer. Irgendwann könnte der Algorithmus Ihr eigenes Abbild erzeugen — das ist zumindest nicht auszuschließen.

Die Wahrscheinlichkeit, dass dies einem normalen Menschen passiert, ist in der Tat gering. Bei bekannten Persönlichkeiten ist dies jedoch sehr viel wahrscheinlicher. Die künstliche Intelligenz hat alle öffentlich zugänglichen Daten erhalten und kennt sie bereits in- und auswendig. Das Einzige, was sich der Betrüger einfallen lassen muss, ist eine geeignete Textaufforderung.

Stable Diffusion-Bilder von Elon Musk in einem Gemälde im Stil von Monet und Bill Gates mit einem Gewehr neben einem Auto. Bild mit freundlicher Genehmigung von Stability AI.

Derzeit gibt es keine Möglichkeit, Ihre Daten davor zu schützen, in den KI-Strom zu gelangen. Sie können Ihre Daten erst im Nachhinein aus dieser improvisierten Kunstklasse entfernen, d. h. nachdem sie bereits als Trainingsmuster für die KI verwendet wurden. Dazu müssen Sie die Daten auf Websites wie Have I Been Trained finden, sich vergewissern, dass sie den Anforderungen entsprechen, eine Beschwerde einreichen und auf das Beste hoffen.

Aktueller Stand der Technologie: Beeindruckend und unordentlich

KI-Bildgeneratoren sind neu auf dem Markt, was zum Teil erklärt, warum sie sich bisher der Regulierung entzogen haben. Eines der bekanntesten und fortschrittlichsten Tools zur Erstellung von Bildern aus einer Beschreibung ist DALL-E. Der Text-zu-Bild-Codierer wurde im Januar letzten Jahres zunächst über eine Warteliste freigegeben und ist seit September dieses Jahres für die Allgemeinheit verfügbar. Nach Angaben von OpenAI, dem Unternehmen, das hinter dem Tool steht, haben bereits 1,5 Millionen Menschen den Dienst genutzt und „über 2 Millionen Bilder pro Tag erstellt“.

Zusammen mit einer Warteliste hat OpenAI die Beschränkungen für die Bearbeitung menschlicher Gesichter aufgehoben. Aber im Gegensatz zu den meisten seiner Konkurrenten hat OpenAI einige Schutzmaßnahmen ergriffen. So sagte OpenAI, dass sie den Filteralgorithmus der KI verfeinert haben, um sexuelle, politische, gewalttätige und hasserfüllte Inhalte zu blockieren. Die Richtlinien von DALLE-E verbieten den Nutzer:innen auch das Hochladen von „Bildern von Personen ohne deren Zustimmung“ und von Bildern, an denen die Nutzer:innen keine Rechte haben.

Um die Risiken eines möglichen Missbrauchs zu minimieren, haben die Entwickler:innen nach eigenen Angaben den Trainingsprozess von DALL-E verfeinert, indem sie seine Fähigkeit, sich Gesichter zu merken, eingeschränkt haben. Dies geschah in erster Linie, damit die KI keine Doppelgänger von Persönlichkeiten des öffentlichen Lebens produziert oder dazu beiträgt, sie in einen irreführenden Kontext zu stellen. Die Inhaltspolitik von OpenAI verbietet ausdrücklich Bilder von „Politiker:innen, Wahlurnen oder anderen Inhalten, die zur Beeinflussung des politischen Prozesses oder zur Durchführung von Kampagnen verwendet werden können“ und warnt vor Versuchen, Bilder von Personen des öffentlichen Lebens zu erstellen. Benutzer:innen haben berichtet, dass DALLE-E tatsächlich nicht auf Aufforderungen zu antworten scheint, die Prominente und Politiker:innen erwähnen.

Trotz seines Namens ist das Text-Bild-Wunder von OpenAI nicht quelloffen, und dafür gibt es einen guten Grund. OpenAI argumentiert, dass „die freie Verfügbarkeit der Rohkomponenten des Systems böswilligen Personen die Möglichkeit bietet, sie auf subjektiv unangemessene Inhalte wie Pornografie und Gewaltdarstellungen zu trainieren“.

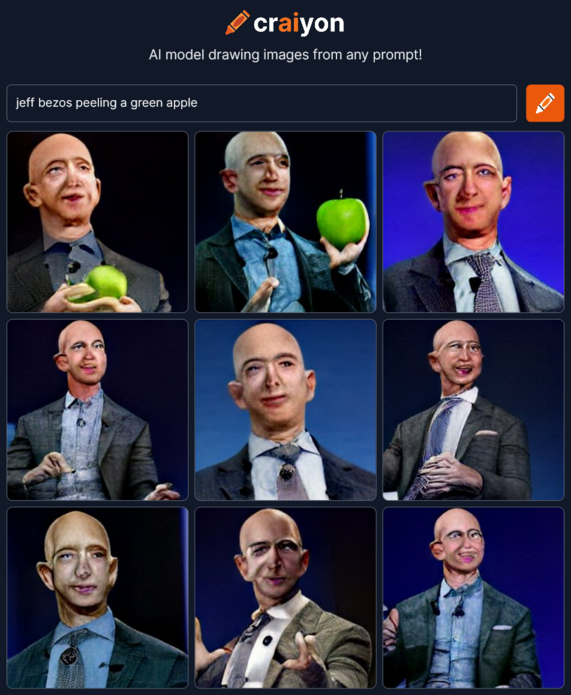

Andere haben jedoch dort weitergemacht, wo OpenAI aufgehört hat. Inspiriert von DALL-E hat eine Gruppe von KI-Enthusiasten Crayion (ehemals DALLE-E mini) entwickelt, einen kostenlosen Open-Source-KI-Generator für die Umwandlung von Text in Bilder. Da er jedoch auf einer relativ kleinen Stichprobe ungefilterter Daten aus dem Internet trainiert wird — etwa 15 Millionen Paare von Bildern und zugehörigen Alt-Texten — sehen die resultierenden Zeichnungen, insbesondere die von Menschen, weit weniger realistisch aus.

Weitaus fortschrittlicher als Crayion und weitaus weniger restriktiv als DALLE-E 2 ist Stable Diffusion, ein Open-Source-Modell, das im August dieses Jahres vom Start-up StabilityAI veröffentlicht wurde. Es ermöglicht die Generierung von Bildern öffentlicher Personen sowie von Protesten und Unfällen, die nie stattgefunden haben und potenziell für Desinformationskampagnen genutzt werden können.

Stable Diffusion-Bilder von Rauchschwaden aus dem Weißen Haus und Protesten in Disneyland. Bild mit freundlicher Genehmigung von Stability AI.

Stable Diffusion erteilt Ihnen die Erlaubnis, Ihre Ergebnisse zu verbreiten und zu verkaufen, sofern Sie eine Liste von Regeln einhalten. So dürfen Sie das Modell beispielsweise nicht verwenden, um gegen Gesetze zu verstoßen, Minderjährigen zu schaden, gefälschte Informationen und medizinische Ratschläge zu erteilen, das Urheberrecht zu verletzen, usw. Auch hier ist es schwer zu sagen, wie das Unternehmen Verstöße erkennen will. Offenbar obliegt es Außenstehenden und den Opfern selbst, die verbotenen Inhalte zu kennzeichnen.

KI-Modelle werden immer besser darin, menschliche Berührungen zu imitieren. Eine Kontroverse brach aus, nachdem dieses Jahr ein nicht-professioneller Künstler den ersten Preis beim Wettbewerb für digitale Kunst der Colorado State Fair erhalten hatte. Der Künstler hatte sein Wert mit einem anderen Text-zu-Bild-KI-Tool, Midjourney, erstellt. Vor nicht allzu langer Zeit hat ein Journalist von The Atlantic Midjourney benutzt, um zwei Bilder des Verschwörungstheoretikers Alex Jones für einen Newsletter zusammenzustellen.

Wir sind sicher, dass KI-gestützte Tools mit der Zeit noch besser werden. Die Forscher, die hinter Googles eigenem Text-zu-Bild-KI-Modell Imagen stehen, behaupten, dass es die neueste Version von DALLE-E — DALLE-E 2 — in Bezug auf Genauigkeit und Bildqualität bereits übertrifft.

Es gibt viele Spekulationen und Unsicherheiten darüber, wie KI-gestützte Bildsynthesizer Kunst und Realität beeinflussen werden. Vieles wird davon abhängen, ob es den Entwickler:innen gelingt, die KI einzudämmen, sowie von den Daten, die sie weiterhin absorbiert.

Woher stammen die Daten?

KI-Modelle wie DALLE-E und Stable Diffusion trainieren auf riesigen Datensätzen, die aus dem gesamten Internet stammen.

So erhielt DALLE-E 2 650 Millionen Text-Bild-Paare, die bereits im Internet verfügbar waren. Stability AI wurde hauptsächlich auf der englischen Teilmenge des LAION-5B-Datensatzes trainiert. LAION 5B (Large-scale Artificial Intelligence Open Network) ist ein Open-Source-Datensatz, der 5,6 Milliarden Bilder aus dem Internet enthält, darunter 2,3 Milliarden Bild-Text-Paare in englischer Sprache, was ihn zum größten offen zugänglichen Bild-Text-Datensatz der Welt macht. Sein Vorgänger, LAION-400, enthält 413 Millionen Paare, und wurde von Google zum Trainieren von Imagen verwendet.

LAION beschreibt sich selbst als gemeinnützige Organisation mit der Aufgabe — „die Forschung und das Experimentieren im Bereich des groß angelegten multimodalen Modelllernens zu demokratisieren“. Diese Mission ist zwar nobel, hat aber einen hohen Preis für die Privatsphäre. Die Daten, die die Forscher analysierten, um Bild-Text-Paare zu finden, stammen von Common Crawl, einer anderen gemeinnützigen Organisation. Diese Organisation durchsucht jeden Monat das Internet und stellt die Daten frei zur Verfügung. In seiner technischen Beschreibung gibt Common Crawl an, dass sie „diese Daten einfach online gefunden haben und nicht für ihren Inhalt bürgen“.

Es ist keine Überraschung, dass sich personenbezogene Daten, sensible Bilder und urheberrechtlich geschützte Inhalte in den Datensatz einschleichen können. ArtTechnica berichtete letzten Monat, wie eine KI-Künstlerin ihre eigenen medizinischen Fotos im LAION-5B-Datensatz entdeckte. Die Fotos wurden von dem (inzwischen verstorbenen) Arzt der Künstlerin aufgenommen und waren nur für den privaten Gebrauch des Arztes bestimmt.

LAION hostet die Bilder nicht, sondern stellt lediglich URLs zur Verfügung, von denen sie heruntergeladen werden können. Daher kann LAION vermutlich nicht für die Verbreitung Ihrer persönlichen Daten oder Ihrer Arbeit verantwortlich gemacht werden. Das bedeutet auch, dass wir rechtlich gegen eine Mauer stoßen, wenn wir versuchen, die Schuldigen für einen möglichen Datenmissbrauch zu finden. Ein weiteres Problem ist, dass es keine Möglichkeit gibt, aus dem KI-Training auszusteigen, und dass man sich verrenken muss, um seine Daten nachträglich zu entfernen.

Wie können Sie Ihre persönlichen Daten aus dem KI-Datensatz entfernen?

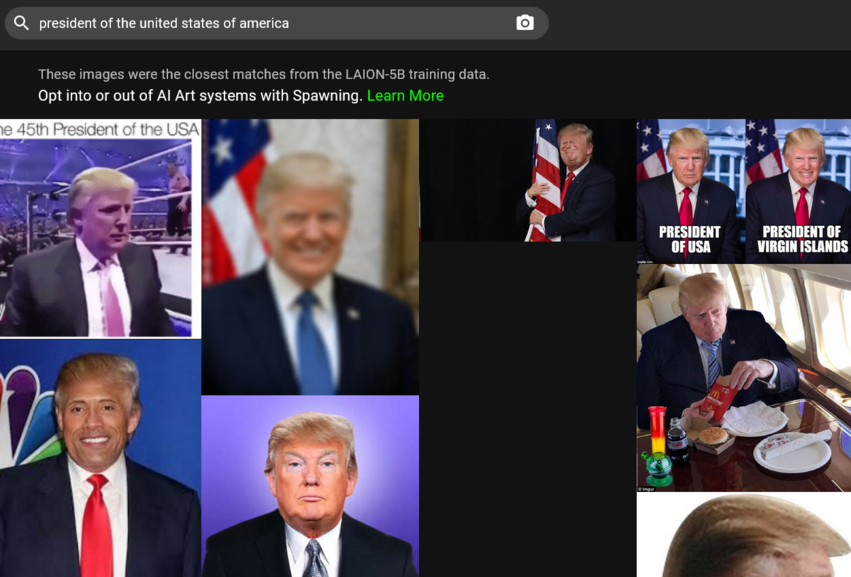

Um die Entfernung Ihrer Bilder aus dem KI-Trainingsdatensatz zu beantragen, müssen Sie sie zunächst einmal dort finden. Das mag angesichts der Millionen von Bild-Text-Paaren, die es zu durchsuchen gilt, eine große Aufgabe sein. Zum Glück gibt es jetzt eine Abkürzung dafür. Letzten Monat hat ein Unternehmen namens Spawning AI „Have I Been Trained?“ ins Leben gerufen, eine Website, auf der Sie die LAION-5B-Datenbank durchsuchen können, indem Sie entweder ein Bild oder eine Textaufforderung eingeben. Sie können aber auch einfach mit dem Algorithmus spielen (Vorsicht, er könnte Ihnen einige sehr merkwürdige Ergebnisse liefern).

Wenn es Ihnen gelingt, Ihr Bild zu finden, müssen Sie auf LAIONs DSGVO-Seite ein Formular zur Löschung des Bildes ausfüllen. LAION verspricht, die Meldung zu untersuchen und, falls das Bild gegen das EU-Datenschutzrecht verstößt, es aus allen Datenspeichern unter seiner Kontrolle und aus künftigen Veröffentlichungen zu entfernen.

Spawning entwickelt auch Tools, die es Künstler:innen ermöglichen, „sich für oder gegen das Training großer KI-Modelle zu entscheiden“ und „Berechtigungen für die Verwendung ihres Stils und ihres Aussehens festzulegen“. Benutzer:innen können sich auf der Website des Unternehmens für den Beta-Zugang zu den Tools bewerben. Stable Diffusion, das die Bemühungen von Spawning unterstützt, erklärt, dass es ein „Opt-in und Opt-out-System für Künstler:innen und andere Personen aufbauen wird, das Dienste in Partnerschaft mit führenden Organisationen nutzen können“.

DALLE-E ermöglicht es Einzelpersonen, die feststellen, dass ihre Arbeit ohne ihre Zustimmung verwendet wurde, die Verletzung an die OpenAI-Mail zu melden. Was die ursprüngliche Quelle eines Großteils der Daten angeht, so scheint Common Crawl nur eine Mailbox aufzuführen, über die Urheberrechtsverletzungen gemeldet werden können.

Wir sind also größtenteils auf uns allein gestellt, wenn es darum geht, dass unsere Daten ohne Zustimmung in das KI-Vakuum fallen. Dies ist zum Teil auf rechtliche Schwierigkeiten zurückzuführen, da jede Seite behauptet, sie sei für das Endergebnis nicht verantwortlich. Zum Teil hat das mit der Funktionsweise des Internets zu tun — es vergisst nie.

Wird die KI Ihr genaues Ebenbild erkennen und kann sie Ihr Aussehen vergessen?

Wie am Beispiel von Persönlichkeiten des öffentlichen Lebens zu sehen ist, kann die KI bei ausreichendem Training erkennbare Bilder von echten Menschen erzeugen. Technisch gesehen hindert die KI nichts daran, den gleichen Trick mit Ihrem Bild zu machen.

OpenAI erklärt, dass DALLE-E 2 zwar nicht „buchstäblich genaue Bilder von Menschen erzeugen kann. Aber es könnte möglich sein, aus den Trainingsdaten eine Ähnlichkeit mit einer Person zu erzeugen“. Die Forschung hat gezeigt, dass Bilder, die von einer anderen Klasse von Deep-Learning-Modellen erzeugt werden — Generative Adversarial Networks (GANs) — echten Menschen ähneln. In einem Artikel mit dem Titel „This Person (Probably) Exists. Identity Membership Attacks Against GAN Generated Faces“ zeigten die Forscher:innen, dass es möglich war, die Identitäten von Quellen zu reidentifizieren, die zur Erzeugung von Bildern von „nicht existierenden Personen“ beitrugen.

Der CEO von Stability AI, Emad Mostaque, antwortete Art Technica auf die Frage über die Möglichkeit, dass KI-Modelle die Informationen über Sie wieder verlernen können. Dies sei möglich, erfordere aber einige Anpassungen oder zusätzliche Arbeit. Die große Frage ist, ob die Entwickler:innen bereit sind, sich dafür viel Mühe zu geben — denn dazu sind sie nicht verpflichtet.

Die Lösung des KI-Problems. Eine unmögliche Mission?

Die von diesen KI-Pionieren erzielten Ergebnisse sind zweifellos bewundernswert. Dass einige davon Open-Source-Code zur Verfügung stellen und wie Stability AI unter einer Lizenz veröffentlichen, die eine kommerzielle Nutzung nicht verbietet, wird Forscher:innen und Entwickler:innen helfen und den Fortschritt fördern.

Dies kann jedoch auch nach hinten losgehen, da es äußerst schwierig ist, Missbrauch des Open-Source-Modells zu verhindern. Am wichtigsten ist vielleicht, dass es derzeit keine Möglichkeit für Künstler:innen und normale Menschen gibt, sich dagegen zu entscheiden, Teil eines von der KI generierten Endprodukts zu werden. Und selbst wenn wir unsere Bilder aus den Trainingsdaten entfernen wollen, sind wir auf den guten Willen der Unternehmen angewiesen.

Diese Probleme werden umso mehr Menschen betreffen, je mehr sich diese Technologien durchsetzen. So hat Microsoft kürzlich angekündigt, dass es zwei seiner Apps in DALL-E 2 integrieren wird. Eine der Apps ist Image Creator, die in der Microsoft-Suchmaschine Bing und in Edge kostenlos verfügbar sein wird.

Die Situation muss geregelt werden. Ob dies durch eine sorgfältige Kuratierung der Datensätze, einen von allen Parteien respektierten Opt-Out-Mechanismus oder durch andere Abhilfemaßnahmen geschieht, wissen wir nicht. Aber so wie es jetzt aussieht, bleiben KI-Bild-zu-Text-Generatoren eine Bedrohung für die Privatsphäre, die nur noch zunehmen wird.