Apples Tracking-Problem, Untergang des KI‑Erkennung‑Tools, Augen‑Scan‑Projekt von OpenAI‑Chef. AdGuards Digest

In dieser Ausgabe von AdGuards Digest: Frankreich ermittelt gegen Apple wegen der Nutzerverfolgung, OpenAI stellt sein KI‑Tool zur Texterkennung ein, Krankenhäuser erhalten eine Warnung über die Datensammlung von Meta und Google, das Nebengeschäft des OpenAI‑CEOs weckt Datenschutzbedenken und Google und Apple arbeiten zusammen, um die unerwünschte AirTag-Verfolgung zu stoppen.

Frankreich ermittelt gegen Apple wegen Positionsmissbrauchs zur Nutzerverfolgung

Eine französische Aufsichtsbehörde hat eine offizielle Untersuchung eingeleitet, um zu prüfen, ob Apple durch die Verfolgung von Personen über seine nativen Apps gegen die Kartellgesetze verstoßen hat. Die Aufsichtsbehörde, L'Autorité de la Concurrence, hat eine Erklärung veröffentlicht, in der sie Cupertino beschuldigt, „seine beherrschende Stellung zu missbrauchen, indem es diskriminierende, nicht objektive und intransparente Bedingungen für die Nutzung von Nutzerdaten zu Werbezwecken auferlegt“.

Die Aufsichtsbehörde meinte damit, dass Apple die von seinen eigenen Apps (z. B. Nachrichten und Aktien) gesammelten Daten verwendet, um Nutzer:innen im eigenen iOS‑Ökosystem zu verfolgen. Doch im Gegensatz zu Apps von Drittanbietern müssen sie die Nutzer:innen nicht um Erlaubnis bitten, sie zu verfolgen. Apple beharrt nämlich darauf, dass es sich dabei nicht um Tracking handelt, weil es innerhalb der eigenen Plattform bleibt. Die Drittanbieter sind jedoch anderer Meinung und beschuldigen Apple der Heuchelei. Die Untersuchung der französischen Aufsichtsbehörde geht zurück auf die 2020 eingereichte Beschwerde von „Opfern“ der Apple‑Politik, die mit geringeren Werbeeinnahmen von Nutzer:innen rechnen müssen, die sich auf Drängen von Apple das Tracking durch Dritte abgelehnt haben.

Wir haben bereits darüber geschrieben, wie Apple mit seiner App‑Tracking-Transparenz-Funktion (ATT) gegen das Tracking durch Dritte vorgehen will. Es scheint, dass die französische Aufsichtsbehörde von Apples semantischer Ausrede nicht beeindruckt ist. Was immer auch als Nächstes kommt, wir halten ATT für großartig. Die Funktion hat dazu beigetragen, das Tracking einzudämmen, aber wir würden gerne sehen, dass jedes Tracking als solches gekennzeichnet wird, egal, woher es kommt.

OpenAI zieht sein KI‑Tool zur Texterkennung wegen geringer Genauigkeit zurück

OpenAI riskiert, alle Lehrkräfte auf der ganzen Welt zu enttäuschen, und hat sein Tool „KI‑Klassifikator“, das zwischen von Menschen geschriebenen und von KI generierten Text unterscheiden sollte, auf Eis gelegt. In einem Bericht erklärte OpenAI, dass das Tool „aufgrund seiner geringen Genauigkeit“ eingestellt wurde.

Der Klassifikator, der einst die Rettung für die Lehrer:innen zu sein schien, bestand ein halbes Jahr lang. Denjenigen, die eine Erklärung zum Start des Programms lasen, könnte selbst das zu lang erscheinen. Schon bei der Einführung des Tools im Januar warnte OpenAI, es sei nicht „völlig zuverlässig“. Und das war eine massive Untertreibung: Die Erklärung zeigte, dass der KI‑Klassifikator nur 26 % der von der KI geschriebenen Texte richtig erkannte, was nach allen Kriterien überhaupt nicht zuverlässig ist.

Als OpenAI das Ende des KI-Klassifikators ankündigte, betonte es, dass es nicht aufgeben werde, wirksame Techniken zu entwickeln, die es ermöglichen, zwischen menschlichem und KI‑generiertem Text sowie zwischen Audio und Bild zu unterscheiden. Das klingt vielversprechend. Der erste Versuch von OpenAI mag zwar ein Fehlschlag gewesen sein, aber solche Tools sind notwendig, nicht nur um Betrüger im Klassenzimmer zu erwischen, sondern auch um den Missbrauch von KI zu verhindern, z. B. für Spam, Falschnachrichten und Deepfakes. Da sich KI jedoch so schnell fortbewegt, können wir nur hoffen, dass die Entwicklung solcher Erkennungstools nicht zu einer unlösbaren Aufgabe wird.

US-Behörden warnen Krankenhäuser: Schützen Sie Patientendaten vor Meta und Google

Das US-Ministerium für Gesundheitspflege und Soziale Dienste und die US‑Bundeshandelskommission haben ein Schreiben an etwa 130 US-Krankenhäuser und Anbieter von Telemedizin verschickt, in dem sie dazu aufgefordert werden, die Weitergabe sensibler Patientendaten an Meta und Google über ihre Websites einzustellen. Im Schreiben werden sie daran erinnert, dass sie gesetzlich verpflichtet sind, die Privatsphäre und die Sicherheit sensibler Gesundheitsdaten wie Diagnosen, Arzttermine und medizinische Behandlungen zu schützen und diese nicht ohne Zustimmung an Dritte weiterzugeben, auch wenn sie keinen Gewinn daraus ziehen.

Das Schreiben ist Teil eines behördlichen Vorgehens gegen Tracking‑Codes, die es Krankenhäusern ermöglichen, das Nutzerverhalten zu Marketingzwecken zu überwachen. Eine kürzlich durchgeführte Untersuchung ergab, dass über 98 % der amerikanischen Krankenhäuser Tracking-Codes von Drittanbietern einbetten, die regelmäßig Patientendaten an große Tech-Unternehmen, soziale Medien, Werbetreibende und Datenvermittler weitergeben. Aufgedeckt wurde diese Praxis durch die Untersuchung von Markup im vergangenen Jahr. Dies führte zu mehreren Klagen gegen Meta wegen der Sammlung von Patientendaten ohne Zustimmung und deren Verwendung für gezielte Werbung auf und außerhalb von Facebook. Meta bestritt alles Fehlverhalten und beschuldigte die Krankenhäuser, weil sie sich für die Einrichtung der Tracker selbst entschieden hatten.

Großartig, dass die USA Maßnahmen ergreifen, um das zügellose Tracking zu verhindern, das Meta und Google auf Websites mit höchst sensiblen gesundheitsbezogenen Informationen betreiben. Die Weitergabe oder der Missbrauch dieser Daten könnte zu Identitätsdiebstahl, Erpressung und öffentlicher Beschämung führen. Wir hoffen, dass die Aufsichtsbehörden diese Angelegenheit weiterverfolgen werden und dass die Krankenhäuser vorsichtiger sind, was die von ihnen verwendeten Analysetools angeht, und dass sie die Privatsphäre der Patienten über ihren eigenen Komfort stellen.

Iris‑Scan‑Projekt des OpenAI‑Chefs löst Datenschutz‑Besorgnis aus

Das neue Kryptowährungsprojekt von OpenAI‑CEO Sam Altman hat in Großbritannien Besorgnis geweckt, da die britische Datenschutzbehörde eine Untersuchung dazu eingeleitet hat. Ziel des Worldcoin Projekts ist es, eine eindeutige digitale ID für jede Person auf der Welt zu schaffen. Diese ID solle unter anderem dazu genutzt werden, um zwischen KI‑Imitation und echten Menschen zu unterscheiden. Die Umsetzung dieser Idee wird jedoch von einigen als störend angesehen.

Für Ihre World ID, auf die Sie über die Worldcoin-App auf dem Smartphone zugreifen können, müssen Sie Ihre Iris mit dem kugelförmigen Gerät, „the Orb“, an einer der Projektstellen scannen. Als Belohnung bekommen Sie Worldcoin (WLD), eine neue Kryptowährung, die, wie man im Projekt hofft, weite Verbreitung finden wird. In 35 Städten in 20 Ländern wurden bereits die Iris gescannt. Unter anderem auch in London, wo die Menschen im Dunklen anstellten, um ihre Augen für etwa 50 Dollar in WLD scannen zu lassen.

Die Sorgen um den Datenschutz drehen sich um den Einsatz von Iris‑Scanning‑Technologie bei Worldcoin und die potenziell weitreichenden Folgen für den Datenschutz und die Sicherheit bei einem Verstoß. Ethereum-Mitbegründer Vitalik Buterin hat in seinem Blogbeitrag auf einige dieser Risiken hingewiesen. Er warnt, dass ein Leck in den Iris-Hash-Daten persönliche Informationen wie Gesundheitszustand, Ethnizität und Geschlecht preisgeben kann. Außerdem gibt es ein wachsendes Problem mit gefälschten Worldcoin-IDs. Dies wird durch Berichte über Menschen in ärmeren Ländern genährt, die bereit sind, ihre Iris zu „verkaufen“, um die Worldcoin-App zu registrieren und die Belohnung zu erhalten.

Wir sind uns nicht sicher, was wir von diesem Projekt halten sollen. Es scheint eine edle Vision zu sein, aber auch viele Schwächen und Unklarheiten zu haben. Vielleicht sollte man nicht gleich die Iris scannen, um Geld zu bekommen.

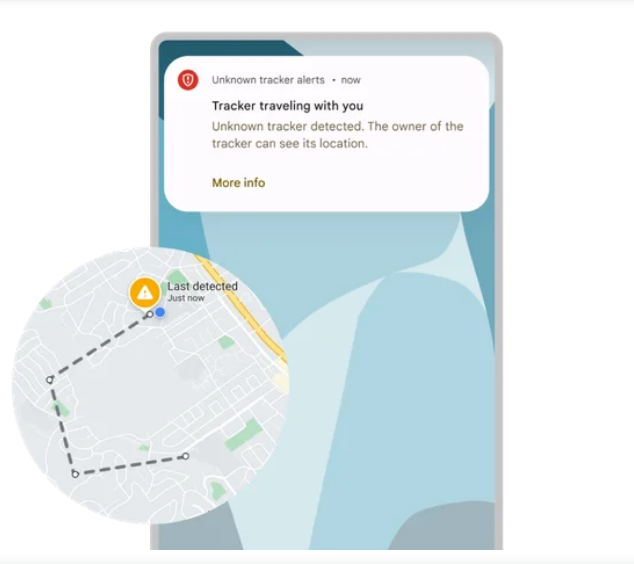

Ihr Android-Handy warnt Sie (endlich), wenn Sie getrackt werden

Mit einer neuen Funktion auf Android-Handys erhalten Sie automatisch eine Warnung, wenn jemand ein Apple-Ortungsgerät, AirTag genannt, verwendet, um Sie ohne Ihre Erlaubnis zu verfolgen. Ab sofort wird Ihnen Ihr Android-Telefon eine Nachricht schicken, wenn es einen unbekannten AirTag erkennt, der Sie begleitet. In der Nachricht erfahren Sie, wo und wann der AirTag angefangen hat, Sie zu verfolgen, und wie Sie den AirTag durch Entfernen der Batterie deaktivieren können. Außerdem können Sie den AirTag einen Ton abspielen lassen, um es zu finden und festzustellen, ob es zu einer Ihnen bekannten Person gehört oder nicht. Zudem können Sie Ihre Umgebung selbst nach AirTags absuchen. In seinem Blog‑Artikel erklärte Google, dass es plant, die Erkennungsfunktion auf andere Bluetooth-betriebene Ortungsgeräte auszuweiten.

AirTag soll Nutzer:innen helfen, ihre Schlüssel und andere verlegte Dinge wiederzufinden. Stattdessen steht der Tracker im Rampenlicht der Medien, vor allem wegen Berichten, dass er zum Verfolgen von Menschen eingesetzt wird. Bisher war es für Android-Nutzer:innen nur möglich, nach AirTags in der Nähe zu suchen, indem sie eine offizielle Tracker-Detect-Anwendung von Apple herunterladen.

Dass Android-Nutzer:innen jetzt einen Weg haben, unerwünschtes Tracking zu vermeiden, ist eine gute Nachricht. Dies ist ein seltenes Beispiel dafür, dass zwei Tech-Giganten, Google und Apple, für eine gute Sache zusammenarbeiten. Hoffentlich sehen wir mehr davon in der Zukunft.